MC

Size: a a a

2020 November 19

не знаю, чем именно до этого грузили, не наша команда была, думаю или jmeter, или lr

MC

меня сейчас больше интересует подход или инструменты работы с данными, значение которых влияет будет тот или иной запрос выполняться при работе с заявкой. Я работала только с jmeter и пока не очень представляю как все реализовать

KY

преобразовать данные в дата пулы, например csv - подставлять на нужном этапе поочередно

VG

Всем привет, сейчас от заказчика поступили требования, хотят провести нагрузку приложения с данными прода.

То есть будет дамп с прода и анализ данных, что определенное кол-во заявок было сделано за сутки/час и точно такое же количество использовать при нагрузку с такими же данными(Пример: повторить заявки со всеми условиями продукта)

Обусловлено данное требование, что много узких мест, которые нагрузка с типичными сценариями их не охватывала, и заказчик огорчался, когда выяснялось все на проде.

Кто-то сталкивался с похожими требованиями? Какие для этого инструменты использовали?

То есть будет дамп с прода и анализ данных, что определенное кол-во заявок было сделано за сутки/час и точно такое же количество использовать при нагрузку с такими же данными(Пример: повторить заявки со всеми условиями продукта)

Обусловлено данное требование, что много узких мест, которые нагрузка с типичными сценариями их не охватывала, и заказчик огорчался, когда выяснялось все на проде.

Кто-то сталкивался с похожими требованиями? Какие для этого инструменты использовали?

Да, как говорит Кирилл.

Ещё советую не вслепую повторять действия прода, а всё-таки постараться их агрегировать-усреднить немного:

Пользователи зачастую делают всё немного по-разному, вам, наверное, воспроизводить это 1в1 не требуется.

Ещё советую не вслепую повторять действия прода, а всё-таки постараться их агрегировать-усреднить немного:

Пользователи зачастую делают всё немного по-разному, вам, наверное, воспроизводить это 1в1 не требуется.

VG

Но на что стоит обратить внимание - это время обработки пользовательских операций.

Стоит посмотреть, в каких случаях времена отклика / время обработки было наивысшим для каждого типа операций и если найдутся пики - подумать, откуда они взялись и как их воспроизвести. Вполне может быть что дело в каких-то особых ТЯЖЁЛЫХ сущностях

Стоит посмотреть, в каких случаях времена отклика / время обработки было наивысшим для каждого типа операций и если найдутся пики - подумать, откуда они взялись и как их воспроизвести. Вполне может быть что дело в каких-то особых ТЯЖЁЛЫХ сущностях

KY

Да верно, 1в1 это нереальный труд, денег выйдет немеренно профита получите в разы меньше. Лучше хотелки по отдельности выполнять

MC

Про 100% повторение убедили, что невозможно

MC

Но все же немного не понимаю, допустим у меня в зависимости от настроек на продукте, идёт разветвление логики и разные отправляются запросы, как в этом случае лучше сделать?

VG

Сперва стоит разделить запросы на те, что можно просто записать и воспроизводить (без параметризации) - и на те, что необходимо параметризовать.

Параметризующиеся надо исследовать и группировать

Параметризующиеся надо исследовать и группировать

VG

Но вообще - я бы сперва предложил разрбраться, а какие проблемы не отловило прошлое НТ,

VG

Может проблема была в плохо составленном профиле или неактуальных скриптах.

VG

А делать просто «чёт не очень вышло, давайте всё с нуля запилим» - может получиться очень долго, больно... и зря

VG

Это реальные кейсы. Недавно мы пропустили багу производительности потому, что не актуализировали скрипт.

Теперь ключевой скрипт будем актуализировать каждый релиз :(

Зато отловили другую - медленно работала заглушка внешней системы.

Но это хорошо, что отловили, потому что система, которую эта заглушка заменяет тоже работает «не очень».

И если у вас проблемы не выявляются в ходе НТ из-за слишком хорошо работающей заглушки, вы хоть 1-в-1 трафик воспроизводите, а проблему не увидите.

Теперь ключевой скрипт будем актуализировать каждый релиз :(

Зато отловили другую - медленно работала заглушка внешней системы.

Но это хорошо, что отловили, потому что система, которую эта заглушка заменяет тоже работает «не очень».

И если у вас проблемы не выявляются в ходе НТ из-за слишком хорошо работающей заглушки, вы хоть 1-в-1 трафик воспроизводите, а проблему не увидите.

MC

Спасибо большое, будем смотреть, предисторию плохо знаю, но меняли точно пару раз команды, видимо результаты не очень нравились, а такое требование выдвигают в формате эксперимента, ну короче как всегда работы дофига, а сроки короткие)

KY

- хотим реалистичное нт, вот вам день.

- хорошо вот вам результаты

- что за это за ужасное нт, надо нанять другую команду и дать им день!

- хорошо вот вам результаты

- что за это за ужасное нт, надо нанять другую команду и дать им день!

l

VG

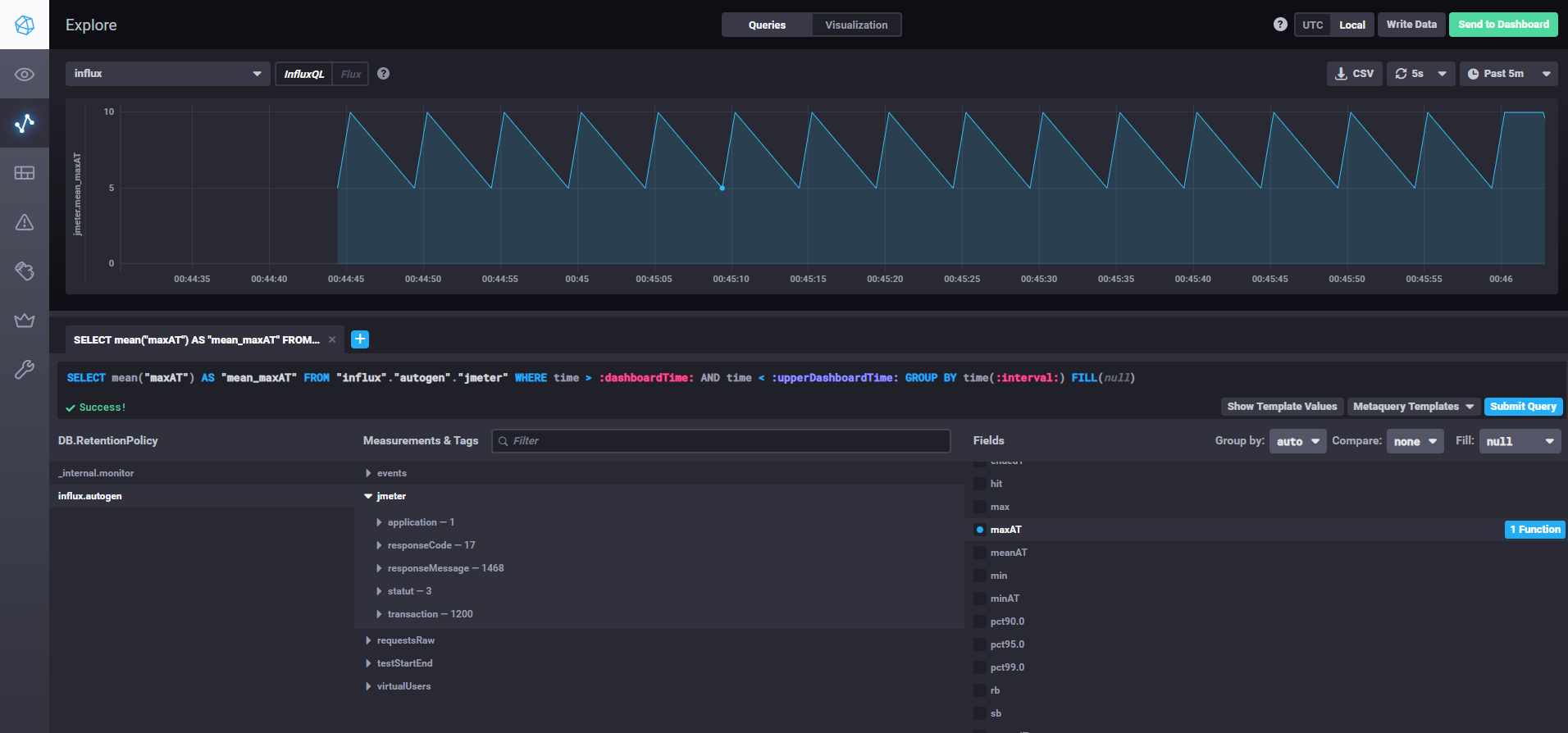

Всем привет, отправляю результаты jmeter в influxdb. Запускаю 2 скрипта для стресс теста, но юзеры не суммируются, а прыгает по юзерам между 1 и 2 скриптом, раньше все суммировалось. Может сталкивались с такой проблемой? (в 1-ом скрипте 10 юзеров, а во 2-ом 5 юзеров, ожидаю что он их сложит до 15)

Группируй за больший отрезок

VG

И сделай не mean а sum

МК

Всем привет, сейчас от заказчика поступили требования, хотят провести нагрузку приложения с данными прода.

То есть будет дамп с прода и анализ данных, что определенное кол-во заявок было сделано за сутки/час и точно такое же количество использовать при нагрузку с такими же данными(Пример: повторить заявки со всеми условиями продукта)

Обусловлено данное требование, что много узких мест, которые нагрузка с типичными сценариями их не охватывала, и заказчик огорчался, когда выяснялось все на проде.

Кто-то сталкивался с похожими требованиями? Какие для этого инструменты использовали?

То есть будет дамп с прода и анализ данных, что определенное кол-во заявок было сделано за сутки/час и точно такое же количество использовать при нагрузку с такими же данными(Пример: повторить заявки со всеми условиями продукта)

Обусловлено данное требование, что много узких мест, которые нагрузка с типичными сценариями их не охватывала, и заказчик огорчался, когда выяснялось все на проде.

Кто-то сталкивался с похожими требованиями? Какие для этого инструменты использовали?

Если честно то звучит для меня что есть дамп данных приложения и можно подготовить среду с идентичным проду наполнением и есть дамп запросов которые нужно повторить

В таком случае как по мне лучше именно повторить запросы с прода.

Если же про дамп запросов я понял не так, а нужно просто взять какую-то заявку и напихать туда всего, тут сомнительно.

В таком случае как по мне лучше именно повторить запросы с прода.

Если же про дамп запросов я понял не так, а нужно просто взять какую-то заявку и напихать туда всего, тут сомнительно.

l

И сделай не mean а sum

Помогло, спасибо. Низких вам респонсов