Вы имеете ввиду Loop count поставить например 20 и уменьшить users в 20 раз что бы машину не перегружать?

Да. Именно так.

Вот этот вариант, который вы сначала описали. Фактически, единственный вариант реализации открытой модели нагрузки в JMeter. Но такой необычной - постоянная нагрузка с открытой моделью. В этой модели количество подключений/потоков может расти до бесконечности. На деле это приведёт к Out of memory error.

Чтобы этого не допускать. Можно использовать закрытую модель нагрузки, когда есть пул потоков, ограниченный сверху и таймеры.

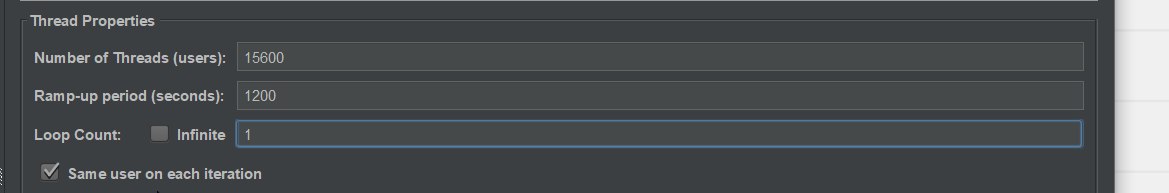

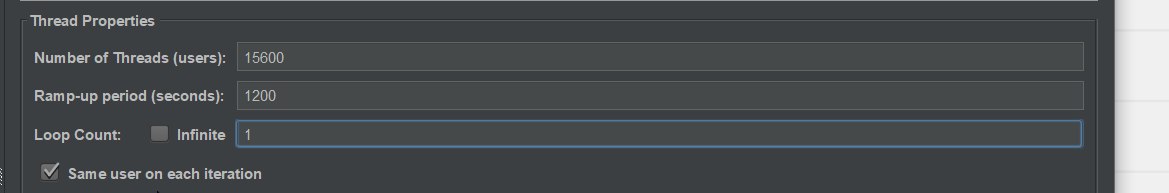

Или использовать полумеру - переиспользовать потоки для эмуляции нескольких виртуальных пользователей (VU), например, 10 или 20 Loop Count. Недостатки тут такие - график нагрузки не будет таким же гладким, как при Loop Count == 1. Но в среднем, интенсивность будет как надо.