3

Size: a a a

2021 March 24

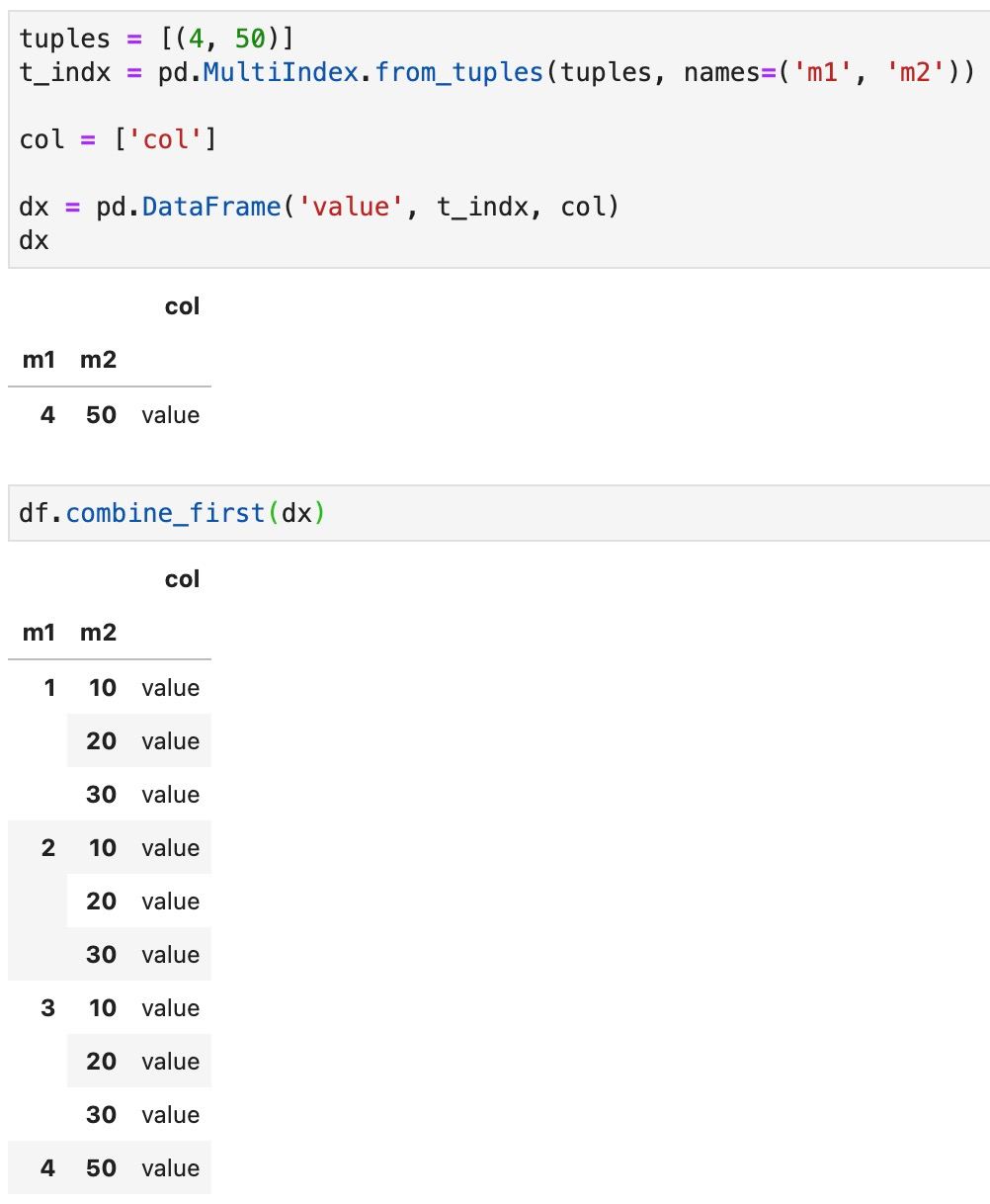

Нужно просто привести к необходимому виду

AK

получается что при создании df надо иметь все индексы и после уже не добавить при варианте с мультииндексом?

Вроде при обычном индексе по другому, если я правильно понимаю своим нубовым умом

Вроде при обычном индексе по другому, если я правильно понимаю своим нубовым умом

3

Не самое элегантное. Можно лучше

3

Гугл выручает, опять же: https://stackoverflow.com/questions/52785579/pandas-dataframe-multiindex-merge/52785602

AK

Сложно так с ним. Понял

ЛЭ

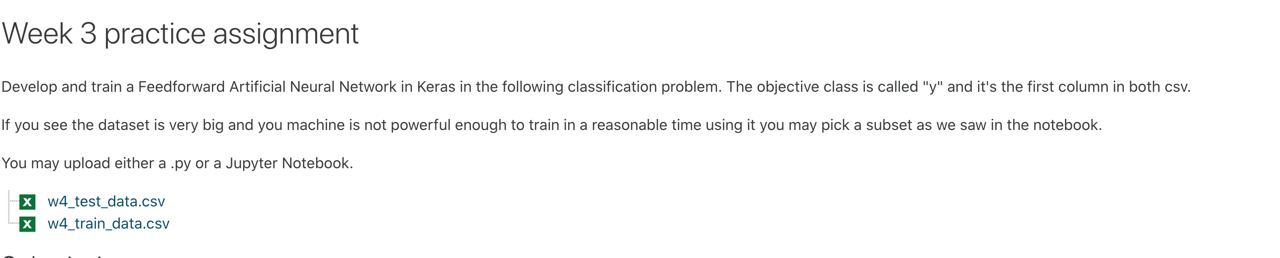

Привет. Для решения университетской задачи мне нужен специалист по библиотеке Keras, напишите, если сможете, скажи стоимость тоже

AK

что-то тип такого, но чтоб первый индекс тоже не создавать

T

$ tesseract all.tif letters.box nobatch box.trainчто я делаю не так? и как узнать подробнее в чем дело? хочу обучить тессеракт на своих картинках

Tesseract Open Source OCR Engine v4.1.1 with Leptonica

Page 1

Error during processing.

АР

В панде же есть встроенный метод подсчёта кумуляты по столбцу?

T

$ tesseract all.tif letters.box nobatch box.trainчто я делаю не так? и как узнать подробнее в чем дело? хочу обучить тессеракт на своих картинках

Tesseract Open Source OCR Engine v4.1.1 with Leptonica

Page 1

Error during processing.

окей, я не учел начало координато внизу. Однако все равно не работает

...

APPLY_BOXES: boxfile line 68/O ((2154,42),(2166,55)): FAILURE! Couldn't find a matching blob

FAIL!

APPLY_BOXES: boxfile line 69/S ((2187,43),(2196,53)): FAILURE! Couldn't find a matching blob

FAIL!

APPLY_BOXES: boxfile line 76/H ((2408,37),(2424,60)): FAILURE! Couldn't find a matching blob

APPLY_BOXES:

Boxes read from boxfile: 76

Boxes failed resegmentation: 66

Found 10 good blobs.

Generated training data for 9 words

T

Я не очень понимаю о каких "словах" идет речь в box файле, например тут https://www.endpoint.com/blog/2018/07/09/training-tesseract-models-from-scratch

AD

В панде же есть встроенный метод подсчёта кумуляты по столбцу?

cumsum штоле?VR

cumsum штоле?+

axis=0

axis=0

LK

Привет! Подскажите как можно с обработкой большого сета справиться?

Pandas ядро умирает через пару операций

Dask не подошёл

Pandas ядро умирает через пару операций

Dask не подошёл

3

Привет! Подскажите как можно с обработкой большого сета справиться?

Pandas ядро умирает через пару операций

Dask не подошёл

Pandas ядро умирает через пару операций

Dask не подошёл

vaex?

SZ

Ещё можно читать чанками через тот же пандас, но тут зависит от того, насколько нужен какой-то агрегированный результат, исходя из всех данных (если это какие-то суммы или средние, то проще через консольные команды посчитать).

Ещё как вариант: поднять какой-нибудь кликхаус у себя на локалке, загрузить данные в таблицу, и потом воспользоваться обычным SQL

Ещё как вариант: поднять какой-нибудь кликхаус у себя на локалке, загрузить данные в таблицу, и потом воспользоваться обычным SQL

2021 March 25

АР

cumsum штоле?да, спасибо.

3

Ещё можно читать чанками через тот же пандас, но тут зависит от того, насколько нужен какой-то агрегированный результат, исходя из всех данных (если это какие-то суммы или средние, то проще через консольные команды посчитать).

Ещё как вариант: поднять какой-нибудь кликхаус у себя на локалке, загрузить данные в таблицу, и потом воспользоваться обычным SQL

Ещё как вариант: поднять какой-нибудь кликхаус у себя на локалке, загрузить данные в таблицу, и потом воспользоваться обычным SQL

+

Ну и кроме того, стоит убедиться, что пандас использует память оптимально — например, посмотреть, каким поля какие форматы присвоены

Ну и кроме того, стоит убедиться, что пандас использует память оптимально — например, посмотреть, каким поля какие форматы присвоены

VR

low_memory=False

может помочь

может помочь

VM

Привет! Подскажите как можно с обработкой большого сета справиться?

Pandas ядро умирает через пару операций

Dask не подошёл

Pandas ядро умирает через пару операций

Dask не подошёл