N

Size: a a a

2020 April 13

А как проявляется ее пропажа?

Y

из-за чего может пропасть consumer группа с кластера?

Может все клиенты отвалились просто?

@

Natalia

А как проявляется ее пропажа?

кондуктор не смог считать)

@

Yuriy

Может все клиенты отвалились просто?

клиент был жив, может повис/залип если только

Y

клиент был жив, может повис/залип если только

Если он завис, то отвалится в рамках sessions.timeout.ms

h

храни агрегат в Кафка стримз State store (он же в будет в топике), коннектором сбрасывай в базу

Проблема с state store в том, что источник правды будет не стрим ивентов, а этот state store, что уже не совсем ES.

“ну короч, это не про ES. это про "доменные ивенты". То есть у тебя стрим ивентов не является источником правды - источник правды это стэйт в твоем state store.

и что бы пофиксить стэйт конкретного агрегата придется перепроиграть весь стрим

и на это время целая партиция будет недоступна для работы

так же ты лишаешься возможности налету врайт модель менять (это оч вкусная фича ES). мол тебе сегодня удобно так стэйт хранить и новая фича и новые ивенты и для этого надо уже чуть по другому а по другому тебе надо делать реплей всех ивентов всех партиций где есть эти агрегат тайпы

словом кафка как шина сообщений хорошо (особенно автоматическая ребалансировка и вот эти все фичи со сторами для того что бы хранить последнее состояние проекции или какие-то курсоры) но как основное хранилище для ES я бы не стал ее юзать. Опять же. может быть если прошариться то можно но... зачем”

“ну короч, это не про ES. это про "доменные ивенты". То есть у тебя стрим ивентов не является источником правды - источник правды это стэйт в твоем state store.

и что бы пофиксить стэйт конкретного агрегата придется перепроиграть весь стрим

и на это время целая партиция будет недоступна для работы

так же ты лишаешься возможности налету врайт модель менять (это оч вкусная фича ES). мол тебе сегодня удобно так стэйт хранить и новая фича и новые ивенты и для этого надо уже чуть по другому а по другому тебе надо делать реплей всех ивентов всех партиций где есть эти агрегат тайпы

словом кафка как шина сообщений хорошо (особенно автоматическая ребалансировка и вот эти все фичи со сторами для того что бы хранить последнее состояние проекции или какие-то курсоры) но как основное хранилище для ES я бы не стал ее юзать. Опять же. может быть если прошариться то можно но... зачем”

2020 April 14

DP

Всем привет, пытаюсь сделать describe группы, но выдает ошибку.

kafka-consumer-groups.sh --describe --group groupname --bootstrap-server 1.2.3.4

[2020-04-14 11:12:08,146] WARN [Consumer clientId=consumer-1, groupId=groupname] Error while fetching metadata with correlation id 11 : {removedtopicname=UNKNOWN_TOPIC_OR_PARTITION} (org.apache.kafka.clients.NetworkClient)

Ранее removedtopicname был удален, и теоретически пока не могу представить что кто-то из него читает, все перепроверил. Если removedtopicname создать заново то kafka-consumer-groups.sh просто бесконечно висит ничего не выводя в консоль. Можно ли как-то заресеттить инфу о консюмергруппе? Версия кафки 1.0.0, инфа хранится не в зукипере вроде как.

kafka-consumer-groups.sh --describe --group groupname --bootstrap-server 1.2.3.4

[2020-04-14 11:12:08,146] WARN [Consumer clientId=consumer-1, groupId=groupname] Error while fetching metadata with correlation id 11 : {removedtopicname=UNKNOWN_TOPIC_OR_PARTITION} (org.apache.kafka.clients.NetworkClient)

Ранее removedtopicname был удален, и теоретически пока не могу представить что кто-то из него читает, все перепроверил. Если removedtopicname создать заново то kafka-consumer-groups.sh просто бесконечно висит ничего не выводя в консоль. Можно ли как-то заресеттить инфу о консюмергруппе? Версия кафки 1.0.0, инфа хранится не в зукипере вроде как.

AS

Всем привет, столкнулись с след. проблемой - во всем ДЦ выключили свет и весь kafka-кластер упал, а после поднятия кластера часть сообщений из топика была удалена.

По логам приложений мы видим, что эти сообщения были запаблишены в kafka (продьюсер получили ack), консьюмеры их прочитали, но после поднятия кластера сообщений в kafka уже не было 🙁

Кластер из 3 нод собран в конфигурации:

По дефолту лидером всегда выбирается 1 нода.

Продьюсер всегда паблишит с ack=all

При поднятии в логах на 1 ноде есть след.:

[2

Собственно вопрос, как можно в будущем избежать таких вот удалений?

По логам приложений мы видим, что эти сообщения были запаблишены в kafka (продьюсер получили ack), консьюмеры их прочитали, но после поднятия кластера сообщений в kafka уже не было 🙁

Кластер из 3 нод собран в конфигурации:

default.replication.factor=3

auto.leader.rebalance.enable=False

unclean.leader.election.enable=False

min.insync.replicas=2

По дефолту лидером всегда выбирается 1 нода.

Продьюсер всегда паблишит с ack=all

При поднятии в логах на 1 ноде есть след.:

[2

020-04-02 16:12:40,892] INFO [Log partition=topic-0, dir=/kafka-data] Recovering unflushed segment 65564239 (kafka.log.Log)о есть получается лидером стала 3 нода и почему-то удалила по ее мнению "лишние" данные.

[2020-04-02 16:12:40,892] INFO [Log partition=topic-0, dir=/kafka-data] Loading producer state till offset 65564239 with message format version 2 (kafka.log.Log)

[2020-04-02 16:12:40,893] INFO [ProducerStateManager partition=topic-0] Loading producer state from snapshot file '/kafka-data/topic-0/00000000000065564239.snapshot' (kafka.log.ProducerStateManager)

[2020-04-02 16:12:43,614] INFO [ProducerStateManager partition=topic-0] Writing producer snapshot at offset 66815821 (kafka.log.ProducerStateManager)

[2020-04-02 16:12:43,614] WARN [Log partition=topic-0, dir=/kafka-data] Corruption found in segment 65564239, truncating to offset 66815821 (kafka.log.Log)

[2020-04-02 16:12:43,662] INFO [Log partition=topic-0, dir=/kafka-data] Loading producer state till offset 66815821 with message format version 2 (kafka.log.Log)

[2020-04-02 16:12:43,664] INFO [ProducerStateManager partition=topic-0] Loading producer state from snapshot file '/kafka-data/topic-0/00000000000066815821.snapshot' (kafka.log.ProducerStateManager)

[2020-04-02 16:12:43,664] INFO [Log partition=topic-0, dir=/kafka-data] Completed load of log with 40 segments, log start offset 0 and log end offset 66815821 in 2778 ms (kafka.log.Log)

...

[2020-04-02 16:12:54,822] INFO [Log partition=topic-0, dir=/kafka-data] Truncating to offset 66815804 (kafka.log.Log)

[2020-04-02 16:12:54,827] INFO [Log partition=topic-0, dir=/kafka-data] Loading producer state till offset 66815804 with message format version 2 (kafka.log.Log)

[2020-04-02 16:12:54,829] INFO [ProducerStateManager partition=topic-0] Loading producer state from snapshot file '/kafka-data/topic-0/00000000000065564239.snapshot' (kafka.log.ProducerStateManager)

[2020-04-02 16:12:54,829] INFO [ProducerStateManager partition=topic-0] Writing producer snapshot at offset 66815804 (kafka.log.ProducerStateManager)

[2020-04-02 16:12:54,857] WARN [ReplicaFetcher replicaId=1, leaderId=3, fetcherId=0] Truncating topic-0 to offset 66815804 below high watermark 66815819 (kafka.server.ReplicaFetcherThread)

Т

Собственно вопрос, как можно в будущем избежать таких вот удалений?

Y

Dmitry P

Всем привет, пытаюсь сделать describe группы, но выдает ошибку.

kafka-consumer-groups.sh --describe --group groupname --bootstrap-server 1.2.3.4

[2020-04-14 11:12:08,146] WARN [Consumer clientId=consumer-1, groupId=groupname] Error while fetching metadata with correlation id 11 : {removedtopicname=UNKNOWN_TOPIC_OR_PARTITION} (org.apache.kafka.clients.NetworkClient)

Ранее removedtopicname был удален, и теоретически пока не могу представить что кто-то из него читает, все перепроверил. Если removedtopicname создать заново то kafka-consumer-groups.sh просто бесконечно висит ничего не выводя в консоль. Можно ли как-то заресеттить инфу о консюмергруппе? Версия кафки 1.0.0, инфа хранится не в зукипере вроде как.

kafka-consumer-groups.sh --describe --group groupname --bootstrap-server 1.2.3.4

[2020-04-14 11:12:08,146] WARN [Consumer clientId=consumer-1, groupId=groupname] Error while fetching metadata with correlation id 11 : {removedtopicname=UNKNOWN_TOPIC_OR_PARTITION} (org.apache.kafka.clients.NetworkClient)

Ранее removedtopicname был удален, и теоретически пока не могу представить что кто-то из него читает, все перепроверил. Если removedtopicname создать заново то kafka-consumer-groups.sh просто бесконечно висит ничего не выводя в консоль. Можно ли как-то заресеттить инфу о консюмергруппе? Версия кафки 1.0.0, инфа хранится не в зукипере вроде как.

Очень старая Кафка, есть смысл обновится

DP

Yuriy

Очень старая Кафка, есть смысл обновится

Эт да.

ЮХ

Всем привет.

Есть люди, кто пользуется apache connect в качестве sink коннектора для postgres?

Нужна помощь, не могу разобраться в чем причина

Есть люди, кто пользуется apache connect в качестве sink коннектора для postgres?

Нужна помощь, не могу разобраться в чем причина

ep

Всем привет, столкнулись с след. проблемой - во всем ДЦ выключили свет и весь kafka-кластер упал, а после поднятия кластера часть сообщений из топика была удалена.

По логам приложений мы видим, что эти сообщения были запаблишены в kafka (продьюсер получили ack), консьюмеры их прочитали, но после поднятия кластера сообщений в kafka уже не было 🙁

Кластер из 3 нод собран в конфигурации:

По дефолту лидером всегда выбирается 1 нода.

Продьюсер всегда паблишит с ack=all

При поднятии в логах на 1 ноде есть след.:

[2

Собственно вопрос, как можно в будущем избежать таких вот удалений?

По логам приложений мы видим, что эти сообщения были запаблишены в kafka (продьюсер получили ack), консьюмеры их прочитали, но после поднятия кластера сообщений в kafka уже не было 🙁

Кластер из 3 нод собран в конфигурации:

default.replication.factor=3

auto.leader.rebalance.enable=False

unclean.leader.election.enable=False

min.insync.replicas=2

По дефолту лидером всегда выбирается 1 нода.

Продьюсер всегда паблишит с ack=all

При поднятии в логах на 1 ноде есть след.:

[2

020-04-02 16:12:40,892] INFO [Log partition=topic-0, dir=/kafka-data] Recovering unflushed segment 65564239 (kafka.log.Log)о есть получается лидером стала 3 нода и почему-то удалила по ее мнению "лишние" данные.

[2020-04-02 16:12:40,892] INFO [Log partition=topic-0, dir=/kafka-data] Loading producer state till offset 65564239 with message format version 2 (kafka.log.Log)

[2020-04-02 16:12:40,893] INFO [ProducerStateManager partition=topic-0] Loading producer state from snapshot file '/kafka-data/topic-0/00000000000065564239.snapshot' (kafka.log.ProducerStateManager)

[2020-04-02 16:12:43,614] INFO [ProducerStateManager partition=topic-0] Writing producer snapshot at offset 66815821 (kafka.log.ProducerStateManager)

[2020-04-02 16:12:43,614] WARN [Log partition=topic-0, dir=/kafka-data] Corruption found in segment 65564239, truncating to offset 66815821 (kafka.log.Log)

[2020-04-02 16:12:43,662] INFO [Log partition=topic-0, dir=/kafka-data] Loading producer state till offset 66815821 with message format version 2 (kafka.log.Log)

[2020-04-02 16:12:43,664] INFO [ProducerStateManager partition=topic-0] Loading producer state from snapshot file '/kafka-data/topic-0/00000000000066815821.snapshot' (kafka.log.ProducerStateManager)

[2020-04-02 16:12:43,664] INFO [Log partition=topic-0, dir=/kafka-data] Completed load of log with 40 segments, log start offset 0 and log end offset 66815821 in 2778 ms (kafka.log.Log)

...

[2020-04-02 16:12:54,822] INFO [Log partition=topic-0, dir=/kafka-data] Truncating to offset 66815804 (kafka.log.Log)

[2020-04-02 16:12:54,827] INFO [Log partition=topic-0, dir=/kafka-data] Loading producer state till offset 66815804 with message format version 2 (kafka.log.Log)

[2020-04-02 16:12:54,829] INFO [ProducerStateManager partition=topic-0] Loading producer state from snapshot file '/kafka-data/topic-0/00000000000065564239.snapshot' (kafka.log.ProducerStateManager)

[2020-04-02 16:12:54,829] INFO [ProducerStateManager partition=topic-0] Writing producer snapshot at offset 66815804 (kafka.log.ProducerStateManager)

[2020-04-02 16:12:54,857] WARN [ReplicaFetcher replicaId=1, leaderId=3, fetcherId=0] Truncating topic-0 to offset 66815804 below high watermark 66815819 (kafka.server.ReplicaFetcherThread)

Т

Собственно вопрос, как можно в будущем избежать таких вот удалений?

По этой проблеме ни у кого нет соображений ? Интересный топик.

VG

Всем привет.

Есть люди, кто пользуется apache connect в качестве sink коннектора для postgres?

Нужна помощь, не могу разобраться в чем причина

Есть люди, кто пользуется apache connect в качестве sink коннектора для postgres?

Нужна помощь, не могу разобраться в чем причина

а что за проблема то?

ЮХ

а что за проблема то?

Пытаюсь записать данные считанные из кафка в постгрес.

После танцев с конфигурацией получаю вот такую ошибку:

Caused by: org.apache.kafka.connect.errors.ConnectException: PK mode for table 'billing_requests' is RECORD_VALUE with configured PK fields [request_id], but record value schema does not contain field: request_id

После танцев с конфигурацией получаю вот такую ошибку:

Caused by: org.apache.kafka.connect.errors.ConnectException: PK mode for table 'billing_requests' is RECORD_VALUE with configured PK fields [request_id], but record value schema does not contain field: request_id

ЮХ

Кусок sink коннектора;

connection.url=jdbc:postgresql://localhost:5432/test

schema.pattern=os_usr

table.name.format=billing_requests

fields.whitelist=request_id,address,city_id,create_time,update_time,closing_class,key_comment,company_id,event_tag,service,ul_agreement_number,fl_agreement_number,plan_group

insert.mode=upsert

auto.create=true

auto.evolve=true

pk.mode=record_value

pk.fields=request_id

db.timezone=UTC

connection.url=jdbc:postgresql://localhost:5432/test

schema.pattern=os_usr

table.name.format=billing_requests

fields.whitelist=request_id,address,city_id,create_time,update_time,closing_class,key_comment,company_id,event_tag,service,ul_agreement_number,fl_agreement_number,plan_group

insert.mode=upsert

auto.create=true

auto.evolve=true

pk.mode=record_value

pk.fields=request_id

db.timezone=UTC

ЮХ

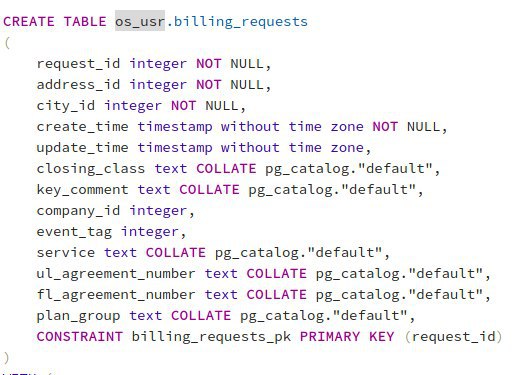

таблица в постгре

ЮХ

Прям закончились идеи, что еще может не нравится.

Или плюнуть на все, не использовать кафка коннект, а брать какой нибудь nifi и на нем крутить?

Или плюнуть на все, не использовать кафка коннект, а брать какой нибудь nifi и на нем крутить?

@

auto.create?

ЮХ

auto.create?

установлен в true.

Важное отклонение, таблица создана в чужой ИС, и мне туда необходимо только вставлять данные.

То есть дать коннектору возможность самому создать для себя структуру не разрешено

Важное отклонение, таблица создана в чужой ИС, и мне туда необходимо только вставлять данные.

То есть дать коннектору возможность самому создать для себя структуру не разрешено

VG

Кусок sink коннектора;

connection.url=jdbc:postgresql://localhost:5432/test

schema.pattern=os_usr

table.name.format=billing_requests

fields.whitelist=request_id,address,city_id,create_time,update_time,closing_class,key_comment,company_id,event_tag,service,ul_agreement_number,fl_agreement_number,plan_group

insert.mode=upsert

auto.create=true

auto.evolve=true

pk.mode=record_value

pk.fields=request_id

db.timezone=UTC

connection.url=jdbc:postgresql://localhost:5432/test

schema.pattern=os_usr

table.name.format=billing_requests

fields.whitelist=request_id,address,city_id,create_time,update_time,closing_class,key_comment,company_id,event_tag,service,ul_agreement_number,fl_agreement_number,plan_group

insert.mode=upsert

auto.create=true

auto.evolve=true

pk.mode=record_value

pk.fields=request_id

db.timezone=UTC

как выглядит сообщение которое улетает из кафки?