A.

Size: a a a

2020 March 12

АБ

docker-compose

A.

docker-compose

!

АБ

а я через что делаю?

Плохо делаешь

АБ

Аппка умирает если нет коннекта?

АБ

Если да - поставить рестарт

A

Как эксплуататор нескольких сервисов с "двойной записью", говорю ответственно - это зло. Укусит в самый неподходящий момент. Надо отдать должное, применение "двойной записи" позволило нам гораздо быстрее двигаться, и в более критичных местах мы её впоследствии выпилили. Но тут важно а) понимать риски б) управлять бэклогом и техническим долгом.

А расскажи подробнее где это выстрелило?:) мы тоже решили, что dual write плохо и сразу без него сделали, теперь проблемы только в теории знаем, но интересно услышать живые примеры

AM

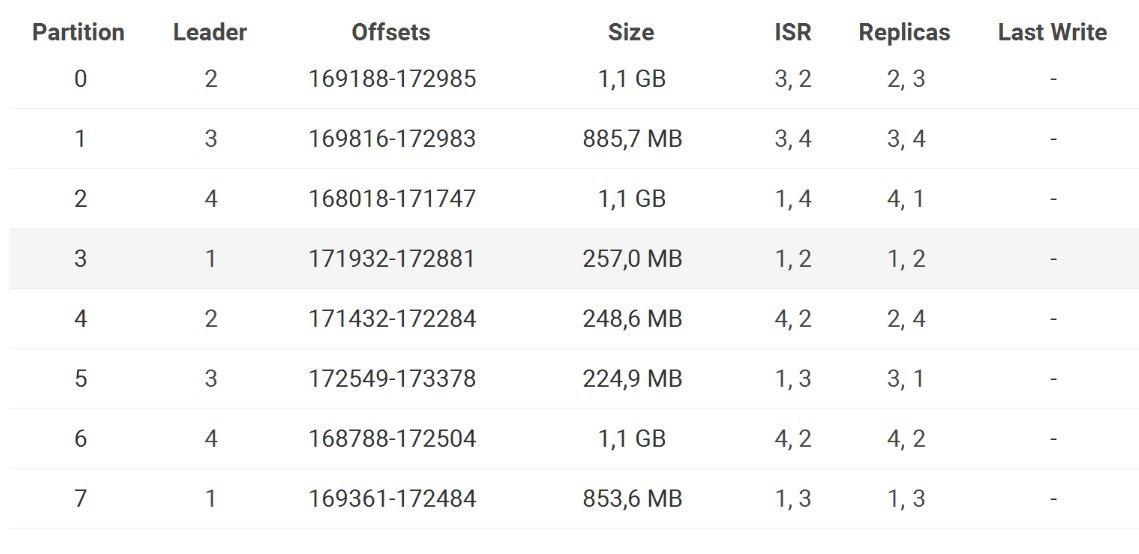

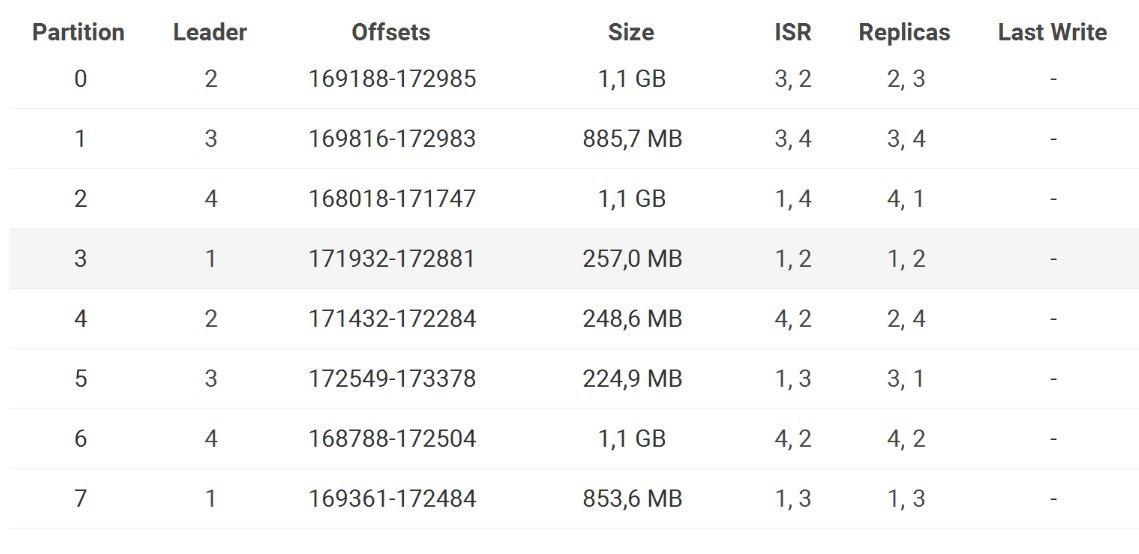

Коллеги, столкнулся со странной ситуацией: не из всех партишенов в топике удаляются данные согласно установленному на топик retention.ms.

Кластер из 4х брокеров kafka_2.11, 8 партиций в топике, фактор репликации 2. Ретeншн на топик - 6 часов. В итоге сейчас в одной партиции нет данных старше 6 часов, в двух - старше 12 часов, в остальных данные двухдневной давности.

Картинка с размерами партиций для иллюстрации.

Подскажите, пожалуйста, куда копать и что крутить?

Кластер из 4х брокеров kafka_2.11, 8 партиций в топике, фактор репликации 2. Ретeншн на топик - 6 часов. В итоге сейчас в одной партиции нет данных старше 6 часов, в двух - старше 12 часов, в остальных данные двухдневной давности.

Картинка с размерами партиций для иллюстрации.

Подскажите, пожалуйста, куда копать и что крутить?

AD

А сегментов сколько ? Какие настройки по сегментации ? log.segment.bytes? lsegment.ms ?

A

Коллеги, столкнулся со странной ситуацией: не из всех партишенов в топике удаляются данные согласно установленному на топик retention.ms.

Кластер из 4х брокеров kafka_2.11, 8 партиций в топике, фактор репликации 2. Ретeншн на топик - 6 часов. В итоге сейчас в одной партиции нет данных старше 6 часов, в двух - старше 12 часов, в остальных данные двухдневной давности.

Картинка с размерами партиций для иллюстрации.

Подскажите, пожалуйста, куда копать и что крутить?

Кластер из 4х брокеров kafka_2.11, 8 партиций в топике, фактор репликации 2. Ретeншн на топик - 6 часов. В итоге сейчас в одной партиции нет данных старше 6 часов, в двух - старше 12 часов, в остальных данные двухдневной давности.

Картинка с размерами партиций для иллюстрации.

Подскажите, пожалуйста, куда копать и что крутить?

Данные в партициях разбиты по сегментам (файлам на диске). Кафка не удаляет активные сегменты (те те, в которые сейчас идёт запись) и периодически создаёт новые сегменты, делая их активными

Если вы хотите примерно 6 часов, настройте ротацию сегментов более частую или их размер поменьше сделайте (дефолтный - гигабайт)

Если вы хотите примерно 6 часов, настройте ротацию сегментов более частую или их размер поменьше сделайте (дефолтный - гигабайт)

VG

Доброе утро. Есть задача переливать данные из кафки заказчика в нашу. Стоим перед выбором: миррор мейкер, uReplicator или допиливать свое приложение (падает при ребалансе кластера-источника). Поделитесь опытом-советами пожалуйста

если есть деньги - купите Skyrim Confluent replicator