AW

Size: a a a

2020 December 02

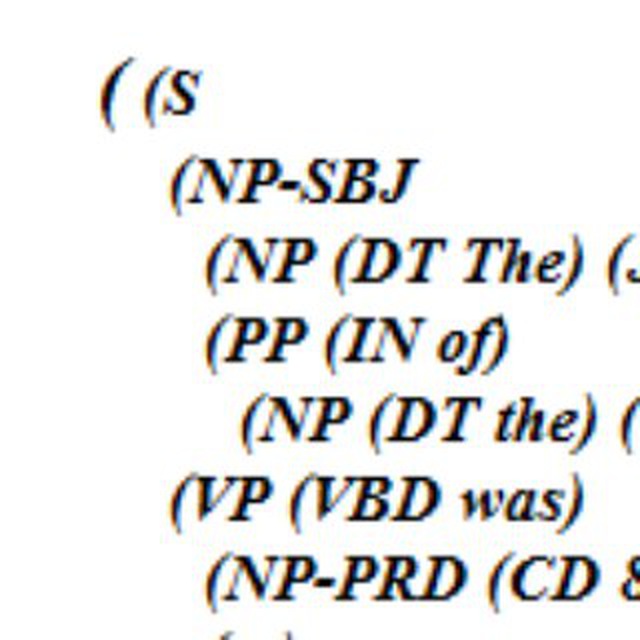

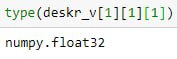

Товарищи, тупой вопрос у меня есит массив документов, внутри которого массивы слов каждого документа внутри которого вектор слова. Вопрос: как загнать все это в вид пригодный для knn

AW

те вектор слов на такой глубине

AK

иными словами, как получить вектор дока из набора векторов слов имеется в виду?

AW

или так

AK

от совсем простых (усреднить), до например таких вариантов

https://github.com/flairNLP/flair/blob/master/resources/docs/TUTORIAL_5_DOCUMENT_EMBEDDINGS.md

https://github.com/flairNLP/flair/blob/master/resources/docs/TUTORIAL_5_DOCUMENT_EMBEDDINGS.md

V

Ребят, обнаружил странную проблему, на сервере стоит модель Pytorch на инференс и чего-то падает, может и вам для ваших проектов полезно будет выяснить:

поставил на Амазон с GPU модель(разговорная, занимает 12гб), все работает, 2 дня работало, и быстро - шлю запросы и на апи фласк и через телеграм общение.

И вот сегодня бот перестал работать, статусы сервера на Амазоне все нормальные. В логах новых ошибок нет, все процессы в supervisor в статусе RUNNING, память выделенная на видеокарте и на рам такая же, не выросла. Не могу понять в чем фишка, особенно смущает, что нет видимых признаков, и нагрузки вроде не было большой - ну в цикле на модель направлял 20 запросов и все было норм. Если перезапускаю процессы, то все снова работает.

Не знаете в чем может быть причина?

поставил на Амазон с GPU модель(разговорная, занимает 12гб), все работает, 2 дня работало, и быстро - шлю запросы и на апи фласк и через телеграм общение.

И вот сегодня бот перестал работать, статусы сервера на Амазоне все нормальные. В логах новых ошибок нет, все процессы в supervisor в статусе RUNNING, память выделенная на видеокарте и на рам такая же, не выросла. Не могу понять в чем фишка, особенно смущает, что нет видимых признаков, и нагрузки вроде не было большой - ну в цикле на модель направлял 20 запросов и все было норм. Если перезапускаю процессы, то все снова работает.

Не знаете в чем может быть причина?

А

Привет всем, есть ли какая то либа или корпус с русскими синонимами?

SS

Ребят, обнаружил странную проблему, на сервере стоит модель Pytorch на инференс и чего-то падает, может и вам для ваших проектов полезно будет выяснить:

поставил на Амазон с GPU модель(разговорная, занимает 12гб), все работает, 2 дня работало, и быстро - шлю запросы и на апи фласк и через телеграм общение.

И вот сегодня бот перестал работать, статусы сервера на Амазоне все нормальные. В логах новых ошибок нет, все процессы в supervisor в статусе RUNNING, память выделенная на видеокарте и на рам такая же, не выросла. Не могу понять в чем фишка, особенно смущает, что нет видимых признаков, и нагрузки вроде не было большой - ну в цикле на модель направлял 20 запросов и все было норм. Если перезапускаю процессы, то все снова работает.

Не знаете в чем может быть причина?

поставил на Амазон с GPU модель(разговорная, занимает 12гб), все работает, 2 дня работало, и быстро - шлю запросы и на апи фласк и через телеграм общение.

И вот сегодня бот перестал работать, статусы сервера на Амазоне все нормальные. В логах новых ошибок нет, все процессы в supervisor в статусе RUNNING, память выделенная на видеокарте и на рам такая же, не выросла. Не могу понять в чем фишка, особенно смущает, что нет видимых признаков, и нагрузки вроде не было большой - ну в цикле на модель направлял 20 запросов и все было норм. Если перезапускаю процессы, то все снова работает.

Не знаете в чем может быть причина?

Чистый фласк в проме?😒 Что даже без nginx и unicorn?!

SS

Это же любые грабли людей, кто пытается работать на чистом фласк- пропажа запросов

V

Чистый фласк в проме?😒 Что даже без nginx и unicorn?!

мм ну пока да. Вообще мы юзаем gunicorn, думал проблема в самом способе хостинга модели может быть. Ок,да, это надо проверить

KS

NLP в последнее время развернулось в направлении ML, что можно легко видеть даже на примере тем этого славного чата. Сторонники RB (Rule-Based), к которым отношусь и я, чувствуют себя грустно и одиноко. Меня тут недавно один знакомый уверял, что ещё год-два, и RB полностью будет поглощён, оставшись лишь на незначительных ролях черновой разметки для моделей ML. Не буду спорить, на мой взгляд в будущем мы увидим гибридные модели, как в машинном переводе. Хочу здесь пропиарить новый чат https://t.me/ASOTRussia, в котором планируется обсуждать темы смысловой обработки текстов, основанные преимущественно на RB-подходе.

MK

мммммм) пожалуй немного людей присоединятся к этому чату)

N

NLP в последнее время развернулось в направлении ML, что можно легко видеть даже на примере тем этого славного чата. Сторонники RB (Rule-Based), к которым отношусь и я, чувствуют себя грустно и одиноко. Меня тут недавно один знакомый уверял, что ещё год-два, и RB полностью будет поглощён, оставшись лишь на незначительных ролях черновой разметки для моделей ML. Не буду спорить, на мой взгляд в будущем мы увидим гибридные модели, как в машинном переводе. Хочу здесь пропиарить новый чат https://t.me/ASOTRussia, в котором планируется обсуждать темы смысловой обработки текстов, основанные преимущественно на RB-подходе.

ну на самом деле даже о той же морфологии до сих пор не так уж редко выходят статьи с использованием конечных автоматов, а вообще много где используют гибридные подходы (прежде всего для посткоррекции вывода нейросеточек), просто они не всегда захайпованы

I

Подскажите, плз, какой сейчас существует современный модный способ уменьшить размерность посимвольных нграм?

Например, 3-граммы на корпусе дают 1,3М уникальных токенов. И пока известный мне способ понизить размерность - это посчитать tfidf для токенов и взять топ К.

Например, 3-граммы на корпусе дают 1,3М уникальных токенов. И пока известный мне способ понизить размерность - это посчитать tfidf для токенов и взять топ К.

OM

Можно hashing trick, вот тут его применяют для нграм https://www.edwardraff.com/publications/hash-grams-faster.pdf

I

Можно hashing trick, вот тут его применяют для нграм https://www.edwardraff.com/publications/hash-grams-faster.pdf

Да, выглядит то что нужно! Спасибо, поизучаю

SM

Привет всем, есть ли какая то либа или корпус с русскими синонимами?

Может,подойдет wiki-ru-wordnet, там можно посмотреть synsets, а ещё в крайнем случа RusVectores most_similar, могут попасться и синонимы.

SM

* и common_ hypernyms

DD

Привет всем, есть ли какая то либа или корпус с русскими синонимами?

Я некоторое время завернул ruwordnet в питон

https://github.com/avidale/python-ruwordnet, не очень эффективно, но поиграться можно.

https://github.com/avidale/python-ruwordnet, не очень эффективно, но поиграться можно.