$

Size: a a a

2020 July 19

а вот например Петропавловск уже не ищет

$

Вообще мне всего то надо выделить название города из строк на русском

$

2020 July 20

AK

Продолжение серии постов про проект Natasha. Что за Наташа? Почему в этот чат? См. https://t.me/natural_language_processing/16962

1. http://natasha.github.io/ner Natasha — качественное компактное решение для извлечения именованных сущностей из новостных статей на русском языке

2. https://t.me/natural_language_processing/17369 Почему Natasha не использует Transformers. BERT в 100 строк.

3. https://natasha.github.io/navec/ Navec — компактные эмбединги для русского языка

#natasha

1. http://natasha.github.io/ner Natasha — качественное компактное решение для извлечения именованных сущностей из новостных статей на русском языке

2. https://t.me/natural_language_processing/17369 Почему Natasha не использует Transformers. BERT в 100 строк.

3. https://natasha.github.io/navec/ Navec — компактные эмбединги для русского языка

#natasha

AK

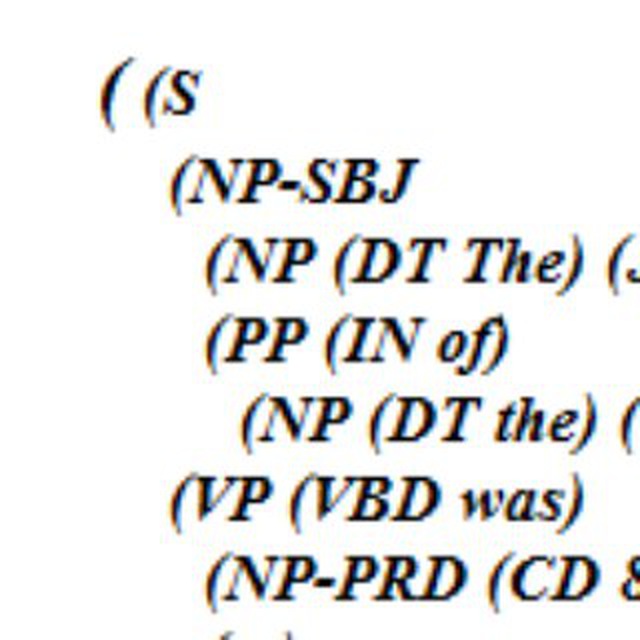

BERT-модели Slovnet

В проекте Natasha в репозитории Slovnet https://github.com/natasha/slovnet сейчас опубликованы компактные модели для русской морфологии, синтаксиса и NER. Качество решений на 1-5 процентных пункта ниже, чем у SOTA-аналогов от DeepPavlov зато размер в 50-100 раз меньше (~30МБ), модели быстро работают на CPU. У инструментов простой интерфейс, есть описание, примеры использования и всё такое. Это публичный API библиотеки, есть ещё непубличная часть, про которую до сих пор нигде не было явно сказано.

Для Slovnet Morph, Syntax и NER есть тяжёлые BERT-аналоги: Slovnet BERT Morph, BERT Syntax и BERT NER. Все дают SOTA или near-SOTA качество, см. замеры https://github.com/natasha/slovnet#evaluation. Модели реализованы немного аккуратнее, чем аналоги в DeepPavlov, архив с весами получается в 2-3 меньше (~500МБ), скорость в ~3 раза выше. Описания нет, но есть jupyter-скрипты для обучения и docker-контейнеры для инференса:

- Slovnet BERT NER https://github.com/natasha/slovnet/blob/master/scripts/02_bert_ner/main.ipynb https://github.com/natasha/slovnet/blob/master/docker/slovnet-ner-bert/app.py

- Slovnet BERT Morph https://github.com/natasha/slovnet/blob/master/scripts/03_bert_morph/main.ipynb https://github.com/natasha/slovnet/blob/master/docker/slovnet-morph-bert/app.py

- Slovnet BERT Syntax https://github.com/natasha/slovnet/blob/master/scripts/04_bert_syntax/main.ipynb https://github.com/natasha/slovnet/blob/master/docker/slovnet-syntax-bert/app.py

#natasha

В проекте Natasha в репозитории Slovnet https://github.com/natasha/slovnet сейчас опубликованы компактные модели для русской морфологии, синтаксиса и NER. Качество решений на 1-5 процентных пункта ниже, чем у SOTA-аналогов от DeepPavlov зато размер в 50-100 раз меньше (~30МБ), модели быстро работают на CPU. У инструментов простой интерфейс, есть описание, примеры использования и всё такое. Это публичный API библиотеки, есть ещё непубличная часть, про которую до сих пор нигде не было явно сказано.

Для Slovnet Morph, Syntax и NER есть тяжёлые BERT-аналоги: Slovnet BERT Morph, BERT Syntax и BERT NER. Все дают SOTA или near-SOTA качество, см. замеры https://github.com/natasha/slovnet#evaluation. Модели реализованы немного аккуратнее, чем аналоги в DeepPavlov, архив с весами получается в 2-3 меньше (~500МБ), скорость в ~3 раза выше. Описания нет, но есть jupyter-скрипты для обучения и docker-контейнеры для инференса:

- Slovnet BERT NER https://github.com/natasha/slovnet/blob/master/scripts/02_bert_ner/main.ipynb https://github.com/natasha/slovnet/blob/master/docker/slovnet-ner-bert/app.py

- Slovnet BERT Morph https://github.com/natasha/slovnet/blob/master/scripts/03_bert_morph/main.ipynb https://github.com/natasha/slovnet/blob/master/docker/slovnet-morph-bert/app.py

- Slovnet BERT Syntax https://github.com/natasha/slovnet/blob/master/scripts/04_bert_syntax/main.ipynb https://github.com/natasha/slovnet/blob/master/docker/slovnet-syntax-bert/app.py

#natasha

AK

Напишите в личку @alexkuk кому интересно почитать статьи для natasha.github.io до публикации. Следующая будет про коллекция датасетов для русскоязычного NLP. С меня ссылочка за неделю до публикации, с вас ревью что непонятно.

2020 July 21

AP

Кто знаком с чтивом, как впечатления? :)

S

Подскажите какая из наработок для русского языка ближе всего к возможностям GPT-3 ?

I

Подскажите какая из наработок для русского языка ближе всего к возможностям GPT-3 ?

ipynb

(локальная шутка)

(локальная шутка)

S

ipynb

(локальная шутка)

(локальная шутка)

а если серьезно? ничего нет? даже уровня GPT-2 на массиве русских текстов?

AK

а если серьезно? ничего нет? даже уровня GPT-2 на массиве русских текстов?

Порфирьевич

SS

Не знаю, какая это классика. Слегка опечалил вот этот параграф о прологе:

"But it can not represent disjunctions or negations: that the capital of California is not Los Angeles, or that the capital of New York is either New York City or Albany." Все совсем не так.

Там они еще вводят DCG-грамматики на Лиспе. Выглядит это весьма забавно. Достаточно просто взять Пролог и пользовать этими DCG-грамматиками. Они встроены прямо в язык.

Это - книжка самого начального уровня по программированию на Лиспе. Все.

"But it can not represent disjunctions or negations: that the capital of California is not Los Angeles, or that the capital of New York is either New York City or Albany." Все совсем не так.

Там они еще вводят DCG-грамматики на Лиспе. Выглядит это весьма забавно. Достаточно просто взять Пролог и пользовать этими DCG-грамматиками. Они встроены прямо в язык.

Это - книжка самого начального уровня по программированию на Лиспе. Все.

S

Порфирьевич

если я правильно нагуглил то звучит как рецепт катастрофы » Обучен на книгах Достоевского, Толстого, Пушкина, Булгакова, Гоголя и Пелевина

I

I

"Norvig introduces Lisp programming in the context of classic AI programs, including General Problem Solver (GPS) from 1959, ELIZA: Dialog with a Machine, from 1966, and STUDENT: Solving Algebra Word Problems, from 1964. The book covers more recent AI programming techniques, including Logic Programming, Object-Oriented Programming, Knowledge Representation, Symbolic Mathematics and Expert Systems."

I

92 год — что вы хотите?

I

GPS есть, Элиза есть — если это не классика, то не знаю, что классика

I

> Это - книжка самого начального уровня по программированию на Лиспе.

так говорят, что лисп для целей ИИ и создан. так что и естественно про ии писать примеры с лиспом)

так говорят, что лисп для целей ИИ и создан. так что и естественно про ии писать примеры с лиспом)