DS

Size: a a a

2021 April 25

и метод SequenceMatcher

IK

https://nlp.stanford.edu/IR-book/html/htmledition/faster-postings-list-intersection-via-skip-pointers-1.html — если вопрос том, как посчитать пересечение двух списков быстрее, чем за O(m + n), то SkipList.

RS

Привет!

Тренирую модель-трансформер для генерации текста. Хочу на каждой интерации (или почти на каждой) вызывать функцию генерации и валидировать результат другой моделью (ее веса заморожены), лосс от которой будет учитываться при тренировке первой модели

На тренировке получаю данные в CPU и потом в forward-фукнции перевожу на GPU. Где стоит держать вторую модель: на GPU или CPU?

Тренирую модель-трансформер для генерации текста. Хочу на каждой интерации (или почти на каждой) вызывать функцию генерации и валидировать результат другой моделью (ее веса заморожены), лосс от которой будет учитываться при тренировке первой модели

На тренировке получаю данные в CPU и потом в forward-фукнции перевожу на GPU. Где стоит держать вторую модель: на GPU или CPU?

О

Вопрос по Наташе. Как из предложения вытащить все существительные?

Пробую из doc.tokens как-то вызвать pos=="Noun", не выходит.

Пробую из doc.tokens как-то вызвать pos=="Noun", не выходит.

О

Если честно я в мануал не въехал, поэтому и спросил. А рабочего примера в инете не нашел.

О

Вот как бывает. Сейчас поныл в чат и сразу разобрался как делать. Спасибо за терпение)

2021 April 26

C

Здравствуйте.

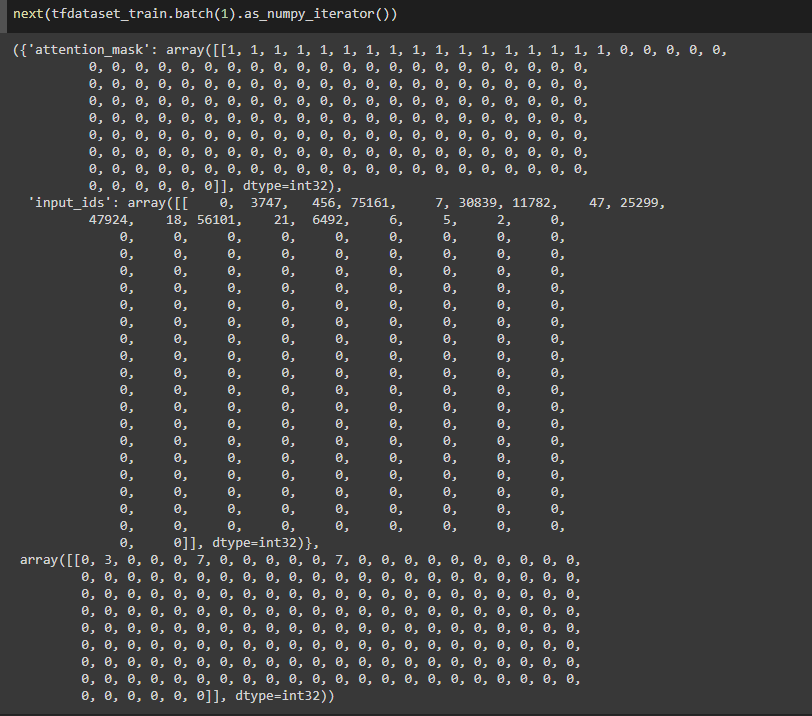

Обращаюсь к спецам по tf. Пытаюсь запустить transformer модель для ner, но модель не учится... думаю что как-то плохо данные подготавливаю. Посмотрите, пожалуйста, в каком виде генератор выдает экземпляр, все ли нормально? Вроде согласно документации все — ({input1: ..., input2 : ...}, target)

Обучаю просто через model.fit()

а в качестве генератора - TensorSliceDataset

Обращаюсь к спецам по tf. Пытаюсь запустить transformer модель для ner, но модель не учится... думаю что как-то плохо данные подготавливаю. Посмотрите, пожалуйста, в каком виде генератор выдает экземпляр, все ли нормально? Вроде согласно документации все — ({input1: ..., input2 : ...}, target)

Обучаю просто через model.fit()

а в качестве генератора - TensorSliceDataset

AC

🚀 "SBERLOGA" представляет необычнейший доклад - дата сайнс (NLP, граф-мл) и философия - присоединяйтесь.

👨🔬 Антон Костин (МФТИ) "Философия на графах"

⌚️ Вторник 27 апреля, 19.00 по Москве

Разберем блокнот с кодом построения графа поверх текстовых эмбеддингов (fasttext).

На примере Louvain посмотрим, как алгоритмы модульности находят философские школы.

В задаче Link Prediction подумаем над неочевидными связями между разными школами и философами.

А также обсудим, будут ли студенты ВУЗов делать домашку по философии с использованием NLP

и дискретной математики (спойлер: на Физтехе уже начали)? Рассказывает преподаватель философии.

Ноутбуки и данные доступы на каггле:

https://www.kaggle.com/visualcomments/philosophy-ru-large

Ваши апвоут, конечно, приветствуются.

Ссылка на зум будет доступна через чат тг чат https://t.me/kg_course ближе к началу доклада.

👨🔬 Антон Костин (МФТИ) "Философия на графах"

⌚️ Вторник 27 апреля, 19.00 по Москве

Разберем блокнот с кодом построения графа поверх текстовых эмбеддингов (fasttext).

На примере Louvain посмотрим, как алгоритмы модульности находят философские школы.

В задаче Link Prediction подумаем над неочевидными связями между разными школами и философами.

А также обсудим, будут ли студенты ВУЗов делать домашку по философии с использованием NLP

и дискретной математики (спойлер: на Физтехе уже начали)? Рассказывает преподаватель философии.

Ноутбуки и данные доступы на каггле:

https://www.kaggle.com/visualcomments/philosophy-ru-large

Ваши апвоут, конечно, приветствуются.

Ссылка на зум будет доступна через чат тг чат https://t.me/kg_course ближе к началу доклада.

AC

Имхо, будет полезно начинающим в НЛП и/или граф-мл.

НК

А что эти связи показывают?

S★

Граф на КДПВ я видел в исследовании данных вики, там у философов есть ссылка-связь "influence" в англоязычной

"Повлиял на", "Испытывал влияние от"

"Повлиял на", "Испытывал влияние от"

AC

Доклад будет завтра , наверно лучше там и спросить. (Не я докладчик)

YS

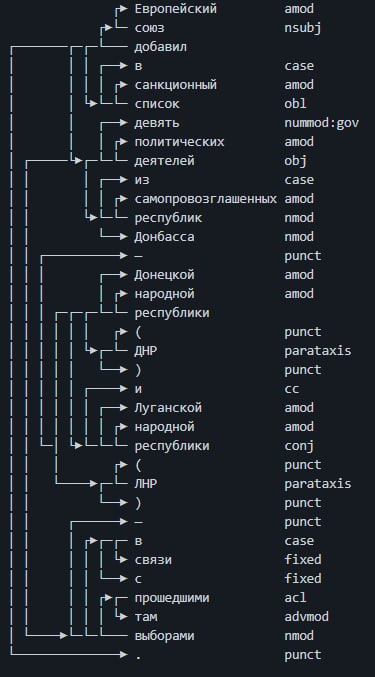

Доброго времени суток. Вопрос по Наташе. Есть ли где-нибудь словарь о частях предложений? не могу разобраться в значениях некоторых из них. Заранее спасибо.

S

Всем привет.

есть ли такая группа на английском языке?

есть ли такая группа на английском языке?

S

спасибо!

YS

Спасибо!!!!!