V

Size: a a a

2019 December 11

A

Добрый вечер! Нужен совет по эмбедингам в керасе. Вот, собственно, формулировка:

https://stackoverflow.com/questions/54551316/keras-extending-embedding-layer-input

Как можно расширить (наследовать) существующие эмбединги?

Подозреваю, что только переобучивать

https://stackoverflow.com/questions/54551316/keras-extending-embedding-layer-input

Как можно расширить (наследовать) существующие эмбединги?

Подозреваю, что только переобучивать

я умею в эмбеддинг слои кераса заливать просто нумпи массив весов

A

соответственно если взять новый размер, в него засунуть значения старого, а остальное рандом, то вот оно и есть

I

Т.е. просто для новых токенов в матрицу добавить новые столбцы?

A

https://github.com/aragaer/human2pa/blob/char/char-train.py#L112 - собственно вот, веса для первого слоя я храню отдельно от всей остальной модели и вот как раз код "загрузить файл весов эмбеддинг слоя и засунуть его"

A

ну я не знаю как "добавить новые столбцы", я бы просто создал новый массив нужного размера, в него скопировал старое через срез

I

Ну да. Спасибо за идею

2019 December 12

A

спасибо за наводку на flair, что-то получается

2019 December 13

SB

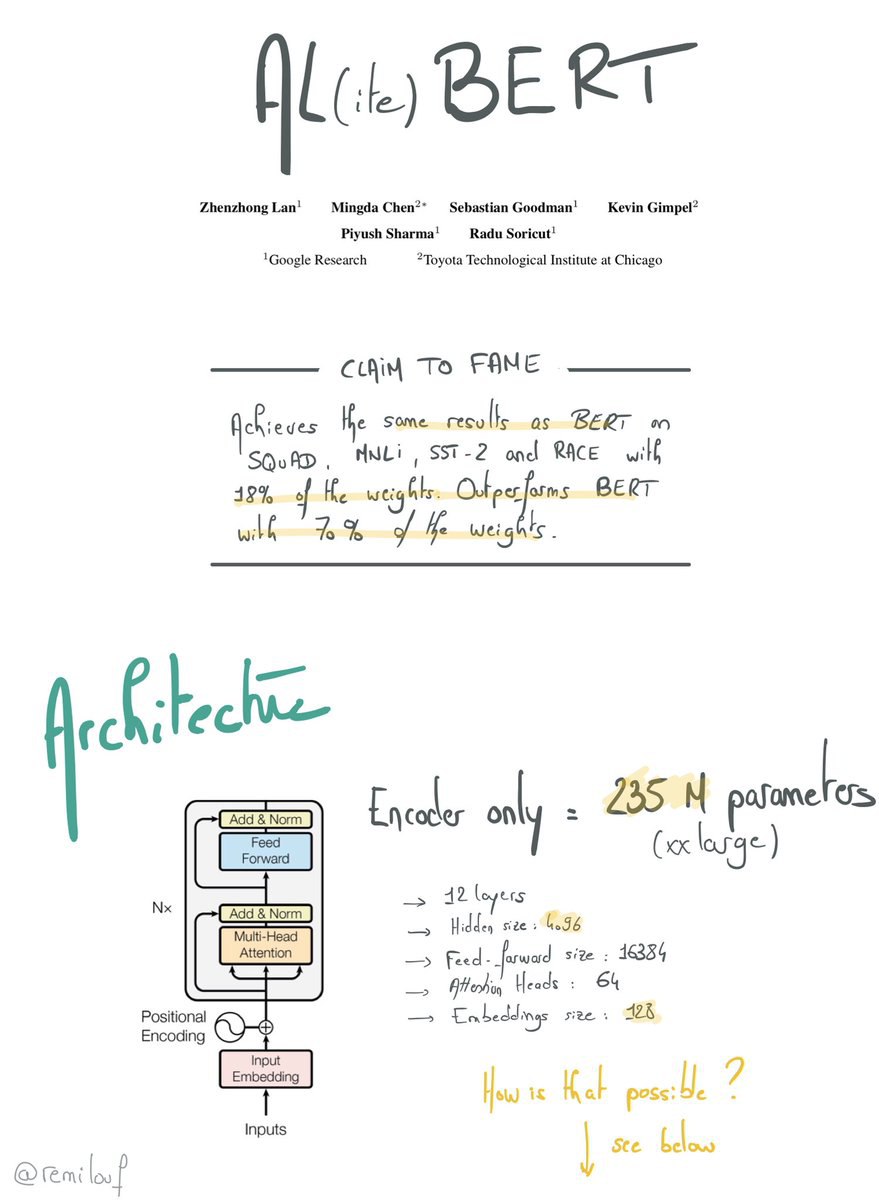

Парни, не подскажете, гугловский BERT, который на Гитхабе ( https://github.com/google-research/bert ) как с русским языком дружит? Пишут, что в BERT недавно большое русскоязычное обновление подвезли:

https://3dnews.ru/999350/?future-link

Но в opensource его, судя по комитам, не выложили

https://3dnews.ru/999350/?future-link

Но в opensource его, судя по комитам, не выложили

DK

Парни, не подскажете, гугловский BERT, который на Гитхабе ( https://github.com/google-research/bert ) как с русским языком дружит? Пишут, что в BERT недавно большое русскоязычное обновление подвезли:

https://3dnews.ru/999350/?future-link

Но в opensource его, судя по комитам, не выложили

https://3dnews.ru/999350/?future-link

Но в opensource его, судя по комитам, не выложили

По-моему они просто выкатили берт в поиск, а авторы новости хайпанули на том, что именно запросы на русском тоже обрабатываются бертом

AS

кто-то сравнивал gpt-2 и bert для задач генерации текстов?

NS

кто-то сравнивал gpt-2 и bert для задач генерации текстов?

Тут и сравнивать не надо, gpt-2 лучше так как для этого предназначена. А берт так, сборная солянка, максимум NER можно делать.

AS

а берт на каких задачах выигрывает?

AS

про сборную солянку не совсем понял, с точки зрения архитектуры системы системы подобны

NS

Целевая функция разная.

AS

ck

Привет. Встречал ли кто-то подобные правила для перевода утверждений в булевую логику? Чтобы самому не писать. Тут функции - предикаты (все возвращают True)

собака лает --> лает(собака)

каждая собака лает --> all([ лает(c) for c in Sobakas ])

сабака или лает или воет --> or(лает(собака), воет(собака))

больше половины собак лает --> len([ лает(с) for c in Собаки ]) > len(Собаки)/2

только одна собака мяукает --> len([ мяукает(с) for c in Собаки ]) == 1

Не в такой псевдопитон конечно, в какую-нибудь логику первого порядка. Не важно в общем то в каком виде результат.

собака лает --> лает(собака)

каждая собака лает --> all([ лает(c) for c in Sobakas ])

сабака или лает или воет --> or(лает(собака), воет(собака))

больше половины собак лает --> len([ лает(с) for c in Собаки ]) > len(Собаки)/2

только одна собака мяукает --> len([ мяукает(с) for c in Собаки ]) == 1

Не в такой псевдопитон конечно, в какую-нибудь логику первого порядка. Не важно в общем то в каком виде результат.

AK

sobakas! 🙂

ck

Shutkas