A

Size: a a a

2019 November 27

1) http://opus.nlpl.eu 2)WMT 3) http://matrix.statmt.org

Спасибо)

2019 November 28

NN

Кто-нибудь знает где можно найти sentiment lexicon для русского? Нашел Rusentilex, но хотел бы ещё другое посмотреть

М

Всем привет. Где можно взять pretrained model для relation extraction для русского языка (e.g. owner_of, founder_of, friend_of etc)? Для английского их море (например https://github.com/thunlp/OpenNRE). Для русского я не нашёл даже dataset'а. В deeppavlov kbqa похоже делается relation extraction. Но разобраться в том, как оно там устроенно (как уже говорили в этом чате) весьма проблематично. Может кто-то видел решение для этой проблемы?

YB

Михаил

Всем привет. Где можно взять pretrained model для relation extraction для русского языка (e.g. owner_of, founder_of, friend_of etc)? Для английского их море (например https://github.com/thunlp/OpenNRE). Для русского я не нашёл даже dataset'а. В deeppavlov kbqa похоже делается relation extraction. Но разобраться в том, как оно там устроенно (как уже говорили в этом чате) весьма проблематично. Может кто-то видел решение для этой проблемы?

для русского датасета можно брать wikidata / conceptnet / babelnet , а потом эту информацию применять на текстах и учить на предложениях, где есть подходящие фразы.

YB

но надо делать самому, да.

rb

Привет, я скачала с deeppavlov ner_rus_bert_v1.tar.gz (архив обычный с model, словарем, meta, чекином и т.д), т.к. мне нужно использовать модель на машине без интернета. Скажите, как ее подгружать, через либу диппавлов или напрямую через tf? И как? Не могу что-то разобраться, спасибо

NS

также и использовать, как в примерах, просто поставить download=False

ner_model = build_model(configs.ner.ner_ontonotes_bert, download=False)

ner_model = build_model(configs.ner.ner_ontonotes_bert, download=False)

rb

также и использовать, как в примерах, просто поставить download=False

ner_model = build_model(configs.ner.ner_ontonotes_bert, download=False)

ner_model = build_model(configs.ner.ner_ontonotes_bert, download=False)

это работает на машине, где уже есть директория .deeppavlov и нужные параметры модели в ней, а у меня, оказалось, не было. но мне вроде подсказали, куда что класть, спасибо :)

DP

Народ нужна помощь

DP

Я делаю проект в processing,и мне надо сделать вторую платформу для игры,пытался добавить - программа посылала нахер меня,как решить проблему?

ck

Привет! Есть вопросы по Yargy. В репозитории на github вроде этот чат указан. Кому написать?

K

да всем писать и норм

ck

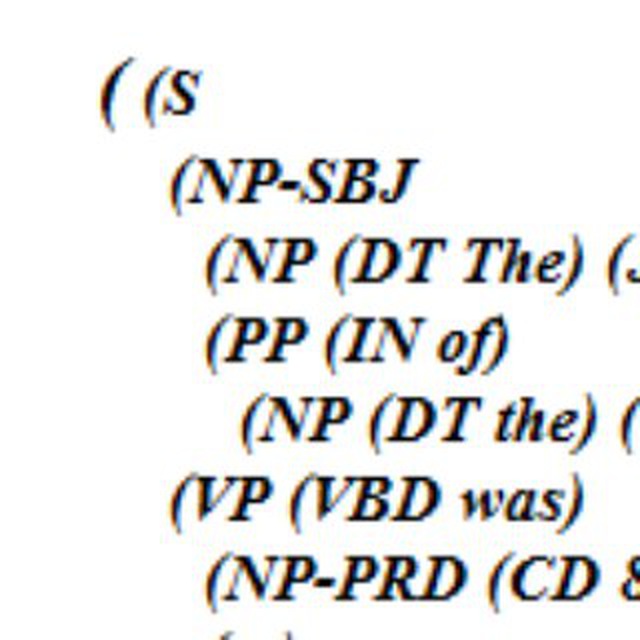

собственно вопрос:

TestRule = fact(

'TestRule',

['key', 'value']

)

TEST_RULE = rule(

eq('word').interpretation(TestRule.key),

not_(eq('word')).repeatable().optional(),

y_type('INT').interpretation(TestRule.value),

).interpretation(

TestRule

)

TXT = 'word foo bar baz 1 2 3'

[m.fact for m in list(Parser(TEST_RULE).findall(TXT))]

Результат - word 3

А я думал будет - word 1

Почему у меня выдяляется последний ИНТ (3)? Как-то не так правило написал, но не пойму, как правильно.

TestRule = fact(

'TestRule',

['key', 'value']

)

TEST_RULE = rule(

eq('word').interpretation(TestRule.key),

not_(eq('word')).repeatable().optional(),

y_type('INT').interpretation(TestRule.value),

).interpretation(

TestRule

)

TXT = 'word foo bar baz 1 2 3'

[m.fact for m in list(Parser(TEST_RULE).findall(TXT))]

Результат - word 3

А я думал будет - word 1

Почему у меня выдяляется последний ИНТ (3)? Как-то не так правило написал, но не пойму, как правильно.

Г

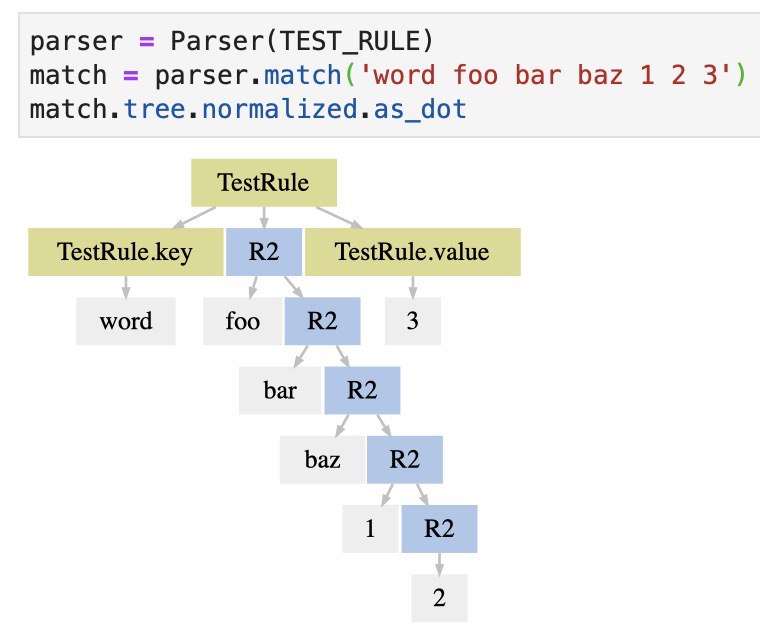

Вот такое дерево выходит

Г

Как пофиксить, я пока не соображу. Давно с ярги не работал

Г

and_(

not_(eq('word')),

not_(y_type('INT')),

).repeatable().optional(),

Вроде должно починить, cnstntn

ck

@ger_ok, спасибо! объясни пожалуйста, почему нужно исключать ИНТ?

Г

Я не особо сведущ в механике самого парсера. Судя по дереву, второе правило продолжает работать, пока есть куда. В принципе логично, ведь "1" вполне себе удовлетворяет

not(eq('word')). Ну а если добавить исключение для ИНТ, то оставновится оно на первом ИНТе.ck

спасибо)

SZ

Михаил

Всем привет. Где можно взять pretrained model для relation extraction для русского языка (e.g. owner_of, founder_of, friend_of etc)? Для английского их море (например https://github.com/thunlp/OpenNRE). Для русского я не нашёл даже dataset'а. В deeppavlov kbqa похоже делается relation extraction. Но разобраться в том, как оно там устроенно (как уже говорили в этом чате) весьма проблематично. Может кто-то видел решение для этой проблемы?

Я как раз искал для английского языка обученные модели, спасибо за ссылку. А где ещё что-то похожее есть (в OpenNRE вижу только одну модель)? Предобучнные модели и датасеты. Особенно интересуют биомедицинские тексты.