MW

Size: a a a

2020 December 18

EG

Referendum::where('id', 1)->update(['result->first->second' => 123]); Вот так тоже не вставляет новый путь, но может обновить , если путь уже существует. Referendum::where('id', 1)->first()->update(['result->first' => 123]); А так создает новый путь.

Ну так делай через второй вариант, или у тебя там туча записей.

А

Ну так делай через второй вариант, или у тебя там туча записей.

именно. Там будет JSON размером с "Войну и мир"

Л

Всем добрый день

Г

здравствуйте

Л

Помогите пожалуйста, по политикам https://laravel.com/docs/8.x/authorization#policy-filters. Перевожу проект с 5.3 на свежую версию)), и соответственно перестал работать метод before в политике. Я так понимаю, что теперь помимо метода before, необходимо указывать все методы для которых нужна проверка, а этот метод теперь просто служит группировкой. Или не так?

EG

именно. Там будет JSON размером с "Войну и мир"

780 кБайт еще никакой сервис не положило, потому если у тебя нет цели делать update сразу всех записей в базе, а делать единичные изменения, то почему бы не делать это через модель, а не через базу данных.

А

780 кБайт еще никакой сервис не положило, потому если у тебя нет цели делать update сразу всех записей в базе, а делать единичные изменения, то почему бы не делать это через модель, а не через базу данных.

780кБайт минус из ОЗУ сервера, а теперь представь, что запрос сразу 1000 чел. делают. Плюс JSON еще надо в цикле переработать. Не лучше ли нагрузку на MySQL перекинуть ?

EG

780кБайт минус из ОЗУ сервера, а теперь представь, что запрос сразу 1000 чел. делают. Плюс JSON еще надо в цикле переработать. Не лучше ли нагрузку на MySQL перекинуть ?

если у тебя такие большие документы, может стоит переформатировать в более близкий к реализационной базе формат или взять mongodb (или что то документно-ориентированное).

ведь когда тебе понадобится работать с этим документом, ты все равно будешь его читать и разворачивать через json_decode эти самые 780 кБайт, а чтений обычно чаще обновлений

при работе сервиса у тебя не будет 1000 одномоментных запросов, хотя может у тебя hiload

ведь когда тебе понадобится работать с этим документом, ты все равно будешь его читать и разворачивать через json_decode эти самые 780 кБайт, а чтений обычно чаще обновлений

при работе сервиса у тебя не будет 1000 одномоментных запросов, хотя может у тебя hiload

А

если у тебя такие большие документы, может стоит переформатировать в более близкий к реализационной базе формат или взять mongodb (или что то документно-ориентированное).

ведь когда тебе понадобится работать с этим документом, ты все равно будешь его читать и разворачивать через json_decode эти самые 780 кБайт, а чтений обычно чаще обновлений

при работе сервиса у тебя не будет 1000 одномоментных запросов, хотя может у тебя hiload

ведь когда тебе понадобится работать с этим документом, ты все равно будешь его читать и разворачивать через json_decode эти самые 780 кБайт, а чтений обычно чаще обновлений

при работе сервиса у тебя не будет 1000 одномоментных запросов, хотя может у тебя hiload

я пока с mongodb не знаком. Чтения документа будет не более , чем обновления. Да и чтение будет кусками. Это легко реализуется. В моем случае , как я выяснил, не желание через DB:: глубже одной вложенности, хотя чтение отличное. Вот бы решить эту проблему.....

ab

Пасаны кто нибудь сталкивался с mix. minify? У меня что то не работает она

ab

наверно потомушто она работает только в прод🤣

V

Здравствуйте! Мы, команда школьников, создаём проект по профессиям в IT-сфере. Нам необходимо провести несколько интервью с работниками данной индустрии. Тех, кто может помочь с этим, прошу отписаться в ЛС.

MW

Здравствуйте! Мы, команда школьников, создаём проект по профессиям в IT-сфере. Нам необходимо провести несколько интервью с работниками данной индустрии. Тех, кто может помочь с этим, прошу отписаться в ЛС.

@vudaltsov вам сюда )

А

Беваре, гайз. Сами не заметите, как на вас будет три кредита, сорок симок и ипотека. Заболтают

V

Спасибо

HS

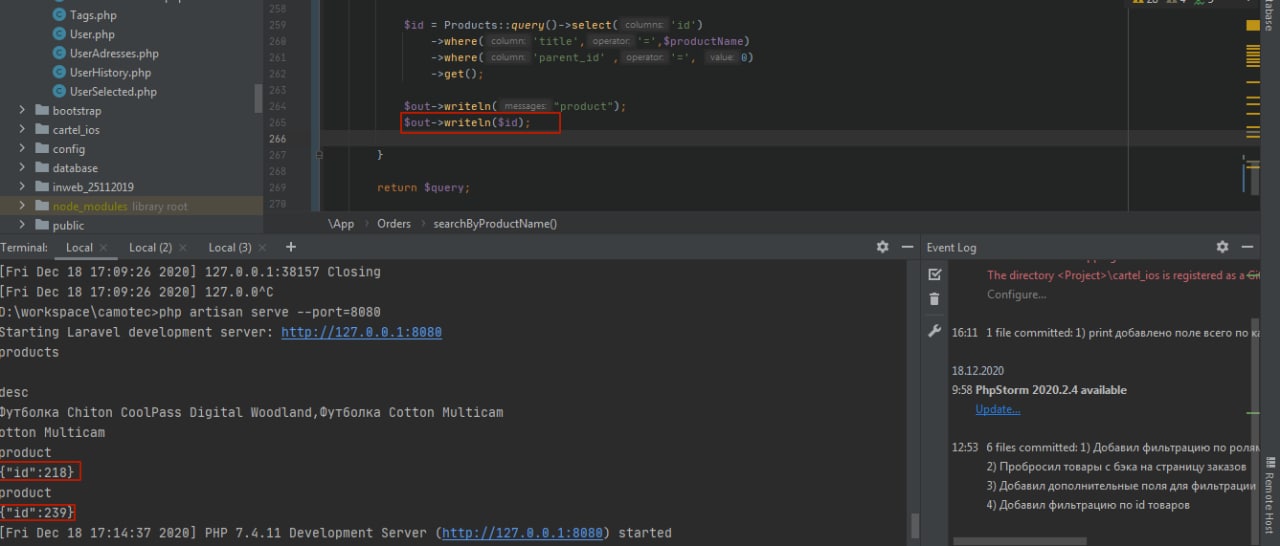

так просто от модели билдер создавай. по типу Order::query()->select(['orders.*'])->innerJoin(...)->where('orders.what_you_want', 1) итп

Спасибо, помог query builder, только там просто join

HS

кто-нибудь может подсказать как распарсить эти айдишники. Не хочу просто регулярками...