AZ

Size: a a a

2021 January 04

10% за бан? Чем же таким он вам насолил?

это фанаты helm и kustomize отсыпали из-за обиды на то, что их любимые тулзы говном назвали :)

GG

это фанаты helm и kustomize отсыпали из-за обиды на то, что их любимые тулзы говном назвали :)

И терраформа

GG

Предлагаю рассматривать "за", я уверен он будет не против :)

Гыгыгы

k

это фанаты helm и kustomize отсыпали из-за обиды на то, что их любимые тулзы говном назвали :)

Так а @gecube за что топит, не уж-то за операторов?

GG

Удивительное рядом !!!!!

S

Противники ранчера решили забанить нашего Жору

GG

Противники ранчера решили забанить нашего Жору

Надо Артема позвать

GG

Будем держать оборону вместе

DS

Я вот щас начал затаскивать приложуху с 6-10K rps. И чет ingress nginx удручает. Сейчас обычный nginx без проблем держит эту нагрузку при этом тратит 3.5 ядра (на 10K rps). А вот nginx ingress у меня сейчас принимает 800-900rps и потребляет 4 ядра. Есть ощущения, что они там упоролись с lua и оно как-то не эффективно работает.

Возможно буду думать об отказе от nginx ingress, если не получится потюнить его

Возможно буду думать об отказе от nginx ingress, если не получится потюнить его

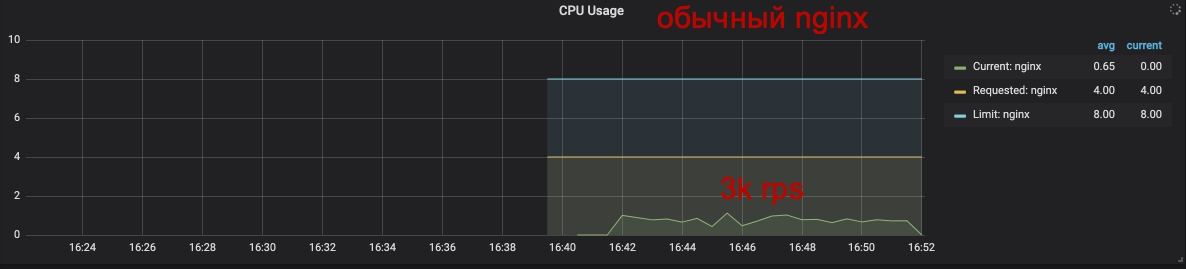

Чет потестил еще и реально беда. Для чистоты эксперемента развернул обычный nginx в кластере на налогочной ноде, тоже с hostNetwork: true. nginx той же версии что и в ingress controller (1.19.4). Подогнал настройки, выставив по возможности аналогичные важные настройки, что часто влияют на производительность nginx: ssl, gzip, worker_*, events, tcp_*, keepalive и т.д.)

И результаты такие-же.

При 3K rps nginx ingress controller потребляет 4 ядра cpu. А обычный nginx максимум одно ядро, но в среднем 0.7-0.8 ядра

И результаты такие-же.

При 3K rps nginx ingress controller потребляет 4 ядра cpu. А обычный nginx максимум одно ядро, но в среднем 0.7-0.8 ядра

СГ

Чет потестил еще и реально беда. Для чистоты эксперемента развернул обычный nginx в кластере на налогочной ноде, тоже с hostNetwork: true. nginx той же версии что и в ingress controller (1.19.4). Подогнал настройки, выставив по возможности аналогичные важные настройки, что часто влияют на производительность nginx: ssl, gzip, worker_*, events, tcp_*, keepalive и т.д.)

И результаты такие-же.

При 3K rps nginx ingress controller потребляет 4 ядра cpu. А обычный nginx максимум одно ядро, но в среднем 0.7-0.8 ядра

И результаты такие-же.

При 3K rps nginx ingress controller потребляет 4 ядра cpu. А обычный nginx максимум одно ядро, но в среднем 0.7-0.8 ядра

нжинкс на ноде работал же наверняка нативно или в контейнере?

DS

👆Обычный nginx

DS

нжинкс на ноде работал же наверняка нативно или в контейнере?

nginx на ноде работал в контейнере, задеплоен в куб также как и ingress controller

GG

Чет потестил еще и реально беда. Для чистоты эксперемента развернул обычный nginx в кластере на налогочной ноде, тоже с hostNetwork: true. nginx той же версии что и в ingress controller (1.19.4). Подогнал настройки, выставив по возможности аналогичные важные настройки, что часто влияют на производительность nginx: ssl, gzip, worker_*, events, tcp_*, keepalive и т.д.)

И результаты такие-же.

При 3K rps nginx ingress controller потребляет 4 ядра cpu. А обычный nginx максимум одно ядро, но в среднем 0.7-0.8 ядра

И результаты такие-же.

При 3K rps nginx ingress controller потребляет 4 ядра cpu. А обычный nginx максимум одно ядро, но в среднем 0.7-0.8 ядра

Луа бесплатно не даётся

DS

Луа бесплатно не даётся

вот видимо да

DS

Луа бесплатно не даётся

луа дается в x4 потребления CPU походу =)

I

траефик например при рпс больше 5к по памяти течет дико

DS

Чет потестил еще и реально беда. Для чистоты эксперемента развернул обычный nginx в кластере на налогочной ноде, тоже с hostNetwork: true. nginx той же версии что и в ingress controller (1.19.4). Подогнал настройки, выставив по возможности аналогичные важные настройки, что часто влияют на производительность nginx: ssl, gzip, worker_*, events, tcp_*, keepalive и т.д.)

И результаты такие-же.

При 3K rps nginx ingress controller потребляет 4 ядра cpu. А обычный nginx максимум одно ядро, но в среднем 0.7-0.8 ядра

И результаты такие-же.

При 3K rps nginx ingress controller потребляет 4 ядра cpu. А обычный nginx максимум одно ядро, но в среднем 0.7-0.8 ядра

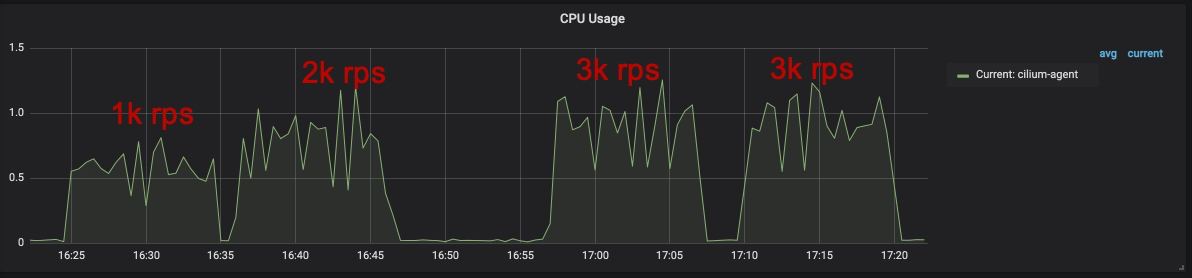

Попутно разочаровался и в cilium. агент на ноде, на которую я отправлял 3К rps, почему-то тоже начинает потреблять CPU 🤷

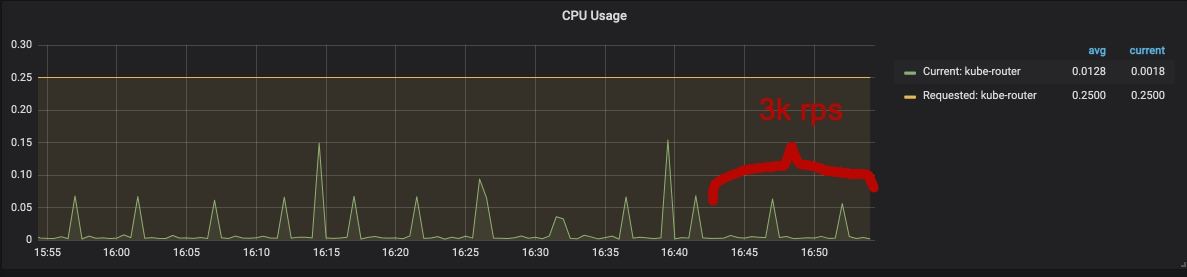

А вот kube-router'у пофиг, есть трафик или нет - потребляет всегда одинаково и совсем чутка

А вот kube-router'у пофиг, есть трафик или нет - потребляет всегда одинаково и совсем чутка

DS

Видимо cilium я так и не завезу себе =). Теперь попутно буду искать другой ingress controller, так как что я еще могу потюнить в nginx ingress controller - я хз. Основные настройки аналогичны обычному nginx.