AV

Size: a a a

2020 October 20

И надежности кластера как не бывало

а это почему? потому что читаемости меньше?

AM

Привет!

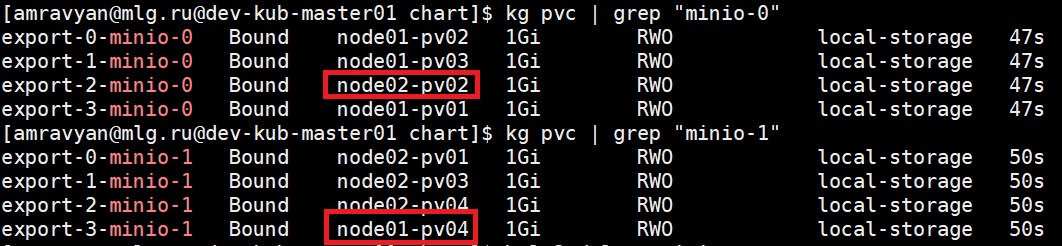

Есть две ноды, на каждой по 4 pv типа local-storage и statefulset из двух реплик, создающий себе по 4 pvc на реплику. Периодически наблюдаю ситуацию, что к pvc биндится pv с соседней ноды (на скриншоте), в результате чего запуск подов блокируется.

Не могу придумать, как исключить подобное поведение на уровне statefulset (без ручного вмешательства в pvc, чтобы не указывать там volumeName). У кого-то есть идеи?

Есть две ноды, на каждой по 4 pv типа local-storage и statefulset из двух реплик, создающий себе по 4 pvc на реплику. Периодически наблюдаю ситуацию, что к pvc биндится pv с соседней ноды (на скриншоте), в результате чего запуск подов блокируется.

Не могу придумать, как исключить подобное поведение на уровне statefulset (без ручного вмешательства в pvc, чтобы не указывать там volumeName). У кого-то есть идеи?

SM

Привет!

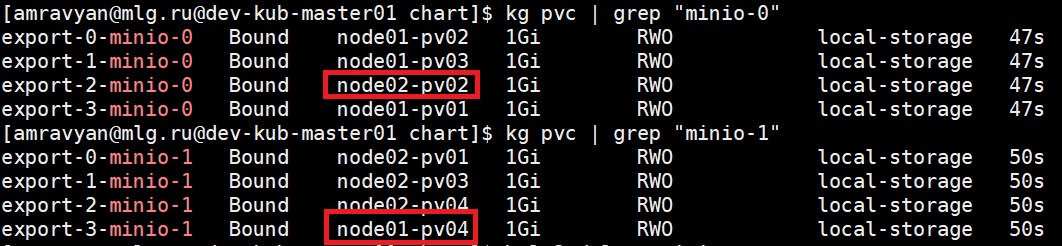

Есть две ноды, на каждой по 4 pv типа local-storage и statefulset из двух реплик, создающий себе по 4 pvc на реплику. Периодически наблюдаю ситуацию, что к pvc биндится pv с соседней ноды (на скриншоте), в результате чего запуск подов блокируется.

Не могу придумать, как исключить подобное поведение на уровне statefulset (без ручного вмешательства в pvc, чтобы не указывать там volumeName). У кого-то есть идеи?

Есть две ноды, на каждой по 4 pv типа local-storage и statefulset из двух реплик, создающий себе по 4 pvc на реплику. Периодически наблюдаю ситуацию, что к pvc биндится pv с соседней ноды (на скриншоте), в результате чего запуск подов блокируется.

Не могу придумать, как исключить подобное поведение на уровне statefulset (без ручного вмешательства в pvc, чтобы не указывать там volumeName). У кого-то есть идеи?

а как у вас pv создан для local-storage? афинити имеется?

G

Привет!

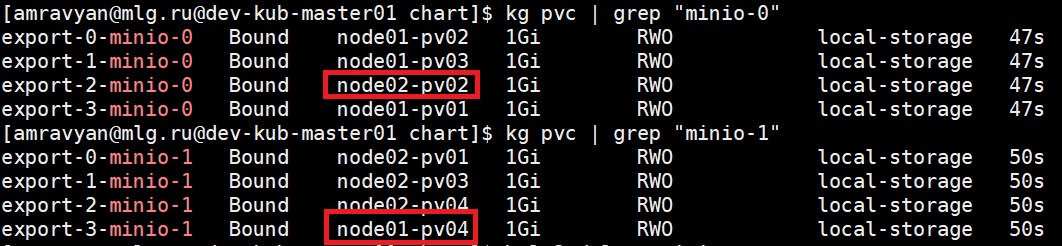

Есть две ноды, на каждой по 4 pv типа local-storage и statefulset из двух реплик, создающий себе по 4 pvc на реплику. Периодически наблюдаю ситуацию, что к pvc биндится pv с соседней ноды (на скриншоте), в результате чего запуск подов блокируется.

Не могу придумать, как исключить подобное поведение на уровне statefulset (без ручного вмешательства в pvc, чтобы не указывать там volumeName). У кого-то есть идеи?

Есть две ноды, на каждой по 4 pv типа local-storage и statefulset из двух реплик, создающий себе по 4 pvc на реплику. Периодически наблюдаю ситуацию, что к pvc биндится pv с соседней ноды (на скриншоте), в результате чего запуск подов блокируется.

Не могу придумать, как исключить подобное поведение на уровне statefulset (без ручного вмешательства в pvc, чтобы не указывать там volumeName). У кого-то есть идеи?

Local Persistent Volumes c volumeBindingMode: WaitForFirstConsumer

S

добрый день! а кто сталкивался с проблемой обновления нод групп(AWS ASG(Spots)), когда подымаешь капасити в два раза всё хорошо, но когда понижаешь её, чтоб остались только новые ноды, когда старые ноды умирают, все поды рекриейтятся полностью(без блу грин), как следствие ловлю даунтайм, так как нжинксы переподымаются, а ELB логично рапартует что ноды OutOfService так как хелсчек не могут пройти, через какое-то время всё возобновляется

можно это как-то обойти всё же? или с этим так и живут?

можно это как-то обойти всё же? или с этим так и живут?

AM

Local Persistent Volumes c volumeBindingMode: WaitForFirstConsumer

🤦♂️ровно такое storageClass был уже, снес его в какой-то момент вместе с pv. Вернул, теперь все ок)

DS

добрый день! а кто сталкивался с проблемой обновления нод групп(AWS ASG(Spots)), когда подымаешь капасити в два раза всё хорошо, но когда понижаешь её, чтоб остались только новые ноды, когда старые ноды умирают, все поды рекриейтятся полностью(без блу грин), как следствие ловлю даунтайм, так как нжинксы переподымаются, а ELB логично рапартует что ноды OutOfService так как хелсчек не могут пройти, через какое-то время всё возобновляется

можно это как-то обойти всё же? или с этим так и живут?

можно это как-то обойти всё же? или с этим так и живут?

а ноды кто дропает? если cluster-autoscaler , то он перед этим эвакуирует поды из ноды. Тут конечно нужен pod distribution budget для надежности

А если у тебя ноды просто дропаются сторонней тулзой, то k8s об этом ничего не знает, соотвественно pod distribution budget тут не поможет, его как минимум надо комибинировать с pod anti affinity. Хотя это тоже может не спасти, если например дропнули три ноды, и все реплики приложения были на них.

А если у тебя ноды просто дропаются сторонней тулзой, то k8s об этом ничего не знает, соотвественно pod distribution budget тут не поможет, его как минимум надо комибинировать с pod anti affinity. Хотя это тоже может не спасти, если например дропнули три ноды, и все реплики приложения были на них.

S

а ноды кто дропает? если cluster-autoscaler , то он перед этим эвакуирует поды из ноды. Тут конечно нужен pod distribution budget для надежности

А если у тебя ноды просто дропаются сторонней тулзой, то k8s об этом ничего не знает, соотвественно pod distribution budget тут не поможет, его как минимум надо комибинировать с pod anti affinity. Хотя это тоже может не спасти, если например дропнули три ноды, и все реплики приложения были на них.

А если у тебя ноды просто дропаются сторонней тулзой, то k8s об этом ничего не знает, соотвественно pod distribution budget тут не поможет, его как минимум надо комибинировать с pod anti affinity. Хотя это тоже может не спасти, если например дропнули три ноды, и все реплики приложения были на них.

ну ноды дропает в случае апгрейда как раз таки механизм автоскейлинга амкзона

DS

ну ноды дропает в случае апгрейда как раз таки механизм автоскейлинга амкзона

ну то есть не cluster-autoscaler? То есть эвакуации подов не происходит перед дропом ноды?

S

ну то есть не cluster-autoscaler? То есть эвакуации подов не происходит перед дропом ноды?

видимо не успевают(

S

или я хз, надо тогда копнуть в автоскейлер

DS

видимо не успевают(

cluster-autosclaer не дропает ноду, пока от туда не эвакуюрует все поды. А если не может это сделать, то ноду он не дропнет. Там даже можно задать параметры дрейна, например дрейнить sts или нет.

DS

или я хз, надо тогда копнуть в автоскейлер

я так понял дропает ноды у тебя не автоскейлер k8s. Он дропает например когда в ноде нет необходимости. Также он дропает только ноды, которые им же создавались. Вручную при уменьшении капасити он не должен этого делать.

S

я так понял дропает ноды у тебя не автоскейлер k8s. Он дропает например когда в ноде нет необходимости. Также он дропает только ноды, которые им же создавались. Вручную при уменьшении капасити он не должен этого делать.

да, как раз для этого я его и юзал, но кейса не замечал с таким даунтаймом, пока больше веб сервисов не завезли в кластер

S

а тут случайно заметил

DS

да, как раз для этого я его и юзал, но кейса не замечал с таким даунтаймом, пока больше веб сервисов не завезли в кластер

pod distribution budget есть для сервисов?

S

pod distribution budget есть для сервисов?

ноуп

DS

ноуп

ну тогда чего ты хотел. Тогда у тебя нет гарантии что у тебя будет всегда запущено минимальное количество реплик приложения. И cluster-autoscaler спокойно будет эвакуировать под приложения, даже если это приводит к тому, что останется 0 реплик при эвакуации

DS

Он кстати даже в логах ругается - не могу эвакурировать потому что pod distribution budget. Потом когда новая реплика поднимается - то спокойно дропает под

S

ну тогда чего ты хотел. Тогда у тебя нет гарантии что у тебя будет всегда запущено минимальное количество реплик приложения. И cluster-autoscaler спокойно будет эвакуировать под приложения, даже если это приводит к тому, что останется 0 реплик при эвакуации

по правде говоря я про pod distribution budget ничего не знал и как-то не было кейса) сейчас читну и покручу) спасибо)