ID

Size: a a a

2021 January 25

Раньше цитадель етим занималась теперь ето часть исиод

4

ну это если у вас мтлс

4

а если нет - то как бы

DP

Igor Dubrovsky

Оно само. Исто сам создаёт и даёт менеджмент внутренним сертам. Нужно полиси определить для стрикт мтлс.

Поглядел докумиентацию самого енвоя и там нет настройки защищенного соединения для отправки трейсов, подозреваю что не поддерживается

DP

https://www.envoyproxy.io/docs/envoy/latest/api-v3/config/trace/v3/zipkin.proto#envoy-v3-api-enum-config-trace-v3-zipkinconfig-collectorendpointversion

This extension is intended to be robust against untrusted downstream traffic. It assumes that the upstream is trusted.

This extension is intended to be robust against untrusted downstream traffic. It assumes that the upstream is trusted.

2021 January 27

4

кто-то делал gzip через istio ingress?

2021 February 01

AP

Всем привет! Простите за простыню...

Я пытаюсь подружить два кластера с истио 1.8.2 по этой инструкции:

https://istio.io/v1.6/docs/setup/install/multicluster/gateways/

Я настроил два кластера, поднял тестовые сервисы и сделал ServiceEntry "httpbin.bar.global" на первом кластере.

Но curl не проходит 🙁

Логи ingressgateway на втором кластере:

20

Я пытаюсь подружить два кластера с истио 1.8.2 по этой инструкции:

https://istio.io/v1.6/docs/setup/install/multicluster/gateways/

Я настроил два кластера, поднял тестовые сервисы и сделал ServiceEntry "httpbin.bar.global" на первом кластере.

Но curl не проходит 🙁

/ # curl httpbin.bar.global:8000

upstream connect error or disconnect/reset before headers. reset reason: connection failure/ #

Логи ingressgateway на втором кластере:

20

21-02-01T10:21:39.250184Z debug envoy filter tls inspector: new connection acceptedВыглядит, будто envoyfilter "istio-multicluster-ingressgateway" не работает.

2021-02-01T10:21:39.250256Z debug envoy filter tls:onServerName(), requestedServerName: outbound_.8000_._.httpbin.bar.global

2021-02-01T10:21:39.250324Z debug envoy filter [C19] new tcp proxy session

2021-02-01T10:21:39.250371Z debug envoy connection [C19] closing data_to_write=0 type=1

2021-02-01T10:21:39.250375Z debug envoy connection [C19] closing socket: 1

2021-02-01T10:21:39.254232Z debug envoy wasm wasm log: [extensions/stats/plugin.cc:633]::report() metricKey cache miss istio_tcp_connections_opened_total , stat=12, recurrent=1

2021-02-01T10:21:39.256882Z debug envoy wasm wasm log: [extensions/stats/plugin.cc:633]::report() metricKey cache miss istio_tcp_sent_bytes_total , stat=16, recurrent=1

2021-02-01T10:21:39.259586Z debug envoy wasm wasm log: [extensions/stats/plugin.cc:633]::report() metricKey cache miss istio_tcp_connections_closed_total , stat=20, recurrent=0

2021-02-01T10:21:39.262097Z debug envoy wasm wasm log: [extensions/stats/plugin.cc:633]::report() metricKey cache miss istio_tcp_received_bytes_total , stat=24, recurrent=1

2021-02-01T10:21:39.320654Z debug envoy filter tls inspector: new connection accepted

2021-02-01T10:21:39.320913Z debug envoy filter tls:onServerName(), requestedServerName: outbound_.8000_._.httpbin.bar.global

2021-02-01T10:21:39.320982Z debug envoy filter [C20] new tcp proxy session

2021-02-01T10:21:39.321022Z debug envoy connection [C20] closing data_to_write=0 type=1

2021-02-01T10:21:39.321026Z debug envoy connection [C20] closing socket: 1

2021-02-01T10:21:39.321142Z debug envoy wasm wasm log: [extensions/stats/plugin.cc:633]::report() metricKey cache miss istio_tcp_connections_opened_total , stat=12, recurrent=1

2021-02-01T10:21:39.321216Z debug envoy wasm wasm log: [extensions/stats/plugin.cc:633]::report() metricKey cache miss istio_tcp_sent_bytes_total , stat=16, recurrent=1

2021-02-01T10:21:39.321233Z debug envoy wasm wasm log: [extensions/stats/plugin.cc:633]::report() metricKey cache miss istio_tcp_connections_closed_total , stat=20, recurrent=0

2021-02-01T10:21:39.321248Z debug envoy wasm wasm log: [extensions/stats/plugin.cc:633]::report() metricKey cache miss istio_tcp_received_bytes_total , stat=24, recurrent=1

AP

И ещё вопрос. Нет ли кого в чате, кто готов меня проконсультировать по истио? Возмездно.

AP

Разобрался как включить правильный дебаг в inressgateway. envoyfilter работает как надо:

То есть, вместо запрошенного ou

2021-02-01T12:43:15.676276Z debug envoy filter tls inspector: new connection accepted

2021-02-01T12:43:15.676313Z trace envoy filter tls inspector: recv: 212

2021-02-01T12:43:15.676337Z trace envoy filter tls:onALPN(), ALPN: istio-http/1.1,istio,http/1.1

2021-02-01T12:43:15.676349Z debug envoy filter tls:onServerName(), requestedServerName: outbound_.8000_._.httpbin.bar.global

2021-02-01T12:43:15.676419Z debug envoy filter [C22] new tcp proxy session

2021-02-01T12:43:15.676424Z trace envoy connection [C22] readDisable: disable=true disable_count=0 state=0 buffer_length=0

2021-02-01T12:43:15.676433Z trace envoy filter [C22] sni_cluster: new connection with server name outbound_.8000_._.httpbin.bar.global

2021-02-01T12:43:15.676440Z trace envoy filter [C22] tcp_cluster_rewrite: new connection with server name outbound_.8000_._.httpbin.bar.global

2021-02-01T12:43:15.676453Z trace envoy filter [C22] tcp_cluster_rewrite: final tcp proxy cluster name outbound_.8000_._.httpbin.bar.svc.cluster.local

2021-02-01T12:43:15.676471Z debug envoy connection [C22] closing data_to_write=0 type=1

2021-02-01T12:43:15.676475Z debug envoy connection [C22] closing socket: 1

То есть, вместо запрошенного ou

tbound_.8000_._.httpbin.bar.global я получаю outbound_.8000_._.httpbin.bar.svc.cluster.local.

Но он опять молча закрывает сокет. Почему, блин?2021 February 02

AP

Я решил свои проблемы с .global (я на него забил, если не модифицировать SNI, то всё работает как надо).

Созрела ещё одна серьёзная проблема.

У меня два кластера с разными clusterDomain и trustDomain (`a.local` и `b.local`). У обоих есть ingressgateway-и для обработки запросов из соседних кластеров.

Если я объявлю сервис

Но я хочу опубликовать все сервисы из соседнего кластера wildard-ом. Если создать

Как мне зарулить все запросы на

Созрела ещё одна серьёзная проблема.

У меня два кластера с разными clusterDomain и trustDomain (`a.local` и `b.local`). У обоих есть ingressgateway-и для обработки запросов из соседних кластеров.

Если я объявлю сервис

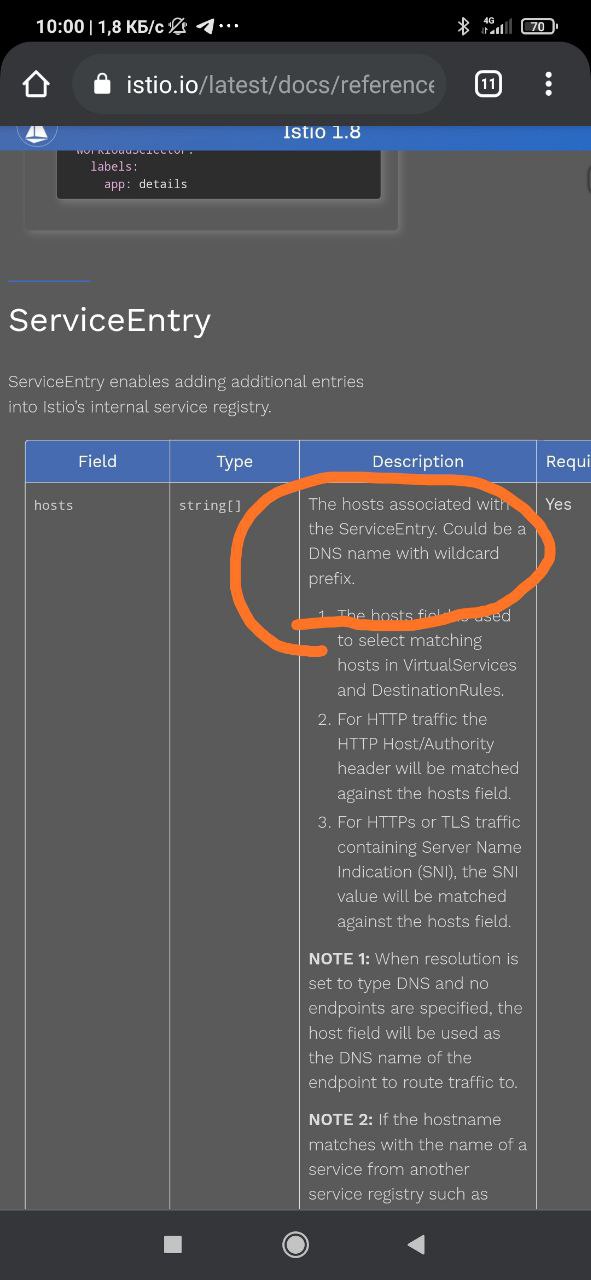

httpbin.bar.svc.b.local в кластере a.local через простой ServiceEntry, то всё работает как положено. Даже авторизация работает по source.principals "a.local/*".Но я хочу опубликовать все сервисы из соседнего кластера wildard-ом. Если создать

ServiceEntry *.b.local, то при запросе httpbin.bar.svc.b.local тот будет перенаправлен в соседний кластер, но его SNI будет заменён на outbound_.8000_._.*.b.local, после чего запрос становится обречён.Как мне зарулить все запросы на

*.b.local на статичный IP:port без модификации SNI? Нет ли у кого идей?4

ᴅ

Я решил свои проблемы с .global (я на него забил, если не модифицировать SNI, то всё работает как надо).

Созрела ещё одна серьёзная проблема.

У меня два кластера с разными clusterDomain и trustDomain (`a.local` и `b.local`). У обоих есть ingressgateway-и для обработки запросов из соседних кластеров.

Если я объявлю сервис

Но я хочу опубликовать все сервисы из соседнего кластера wildard-ом. Если создать

Как мне зарулить все запросы на

Созрела ещё одна серьёзная проблема.

У меня два кластера с разными clusterDomain и trustDomain (`a.local` и `b.local`). У обоих есть ingressgateway-и для обработки запросов из соседних кластеров.

Если я объявлю сервис

httpbin.bar.svc.b.local в кластере a.local через простой ServiceEntry, то всё работает как положено. Даже авторизация работает по source.principals "a.local/*".Но я хочу опубликовать все сервисы из соседнего кластера wildard-ом. Если создать

ServiceEntry *.b.local, то при запросе httpbin.bar.svc.b.local тот будет перенаправлен в соседний кластер, но его SNI будет заменён на outbound_.8000_._.*.b.local, после чего запрос становится обречён.Как мне зарулить все запросы на

*.b.local на статичный IP:port без модификации SNI? Нет ли у кого идей?Serviceentry не поддерживает вайдкар

4

Serviceentry не поддерживает вайдкар

в смысле

4

AP

AP

Но есть нюанс. Он меняет SNI на шаблон.

4

Но есть нюанс. Он меняет SNI на шаблон.

вот эт очень странно

AP

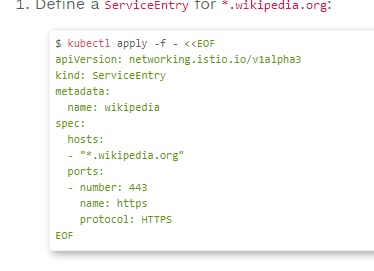

да вроде можно вайлдкарды использовать: https://istio.io/latest/docs/tasks/traffic-management/egress/wildcard-egress-hosts/

Можно, но тут трафик заворачивается на егресс. А мне бы обойтись без него. Я на свежую голову сегодня почитаю ещё разок.

4

ну, я вам честно скажу, я в вашей ситуации не был, потому лучше совета чем этот линк дать не могу)

AP

Понимаю :), всё равно спасибо