АА

Size: a a a

2020 October 28

я прислал команды для консоли

куда?)

АА

hdfs dfsadmin -refreshNodes вроде так

а увидел

2020 October 29

SS

просто интересуюсь (не приходилось делать реликацию hbase кластеров), а чем стандартная репликация не подходит?

а нам нужна репликация из OLTP (HBase) в DWH/DataLake - что только уже не пробовали ((

рады любым советам

рады любым советам

SS

я уже начинаю подозревать, что решение с перенаправлением штатного потока репликации HBase в Кафку и последующее применение этих мутаций HBase в Hudi через сырющщщий partial columns update - единственно возможное!

(это я уныло набросил если что)

(это я уныло набросил если что)

SS

Больше звучит как downstream чем репликация

S

а нам нужна репликация из OLTP (HBase) в DWH/DataLake - что только уже не пробовали ((

рады любым советам

рады любым советам

а вам нужен прямо онлайн?

SS

а вам нужен прямо онлайн?

Да можно и с задержкой до часа

AZ

а нам нужна репликация из OLTP (HBase) в DWH/DataLake - что только уже не пробовали ((

рады любым советам

рады любым советам

а просто писать события в кафку из приложения не вариант?

AZ

просто работа с CDC это компромисс не от хорошей жизни, если у вас есть экспертиза написать приложение поверх hbase, то добавить поток нормальных бизнес-событий оттуда в кафку уж наверняка возможно, и тогда не нужно будет собирать строки, потом интерпретировать бизнес-логику поверх сырых данных...

AZ

а уж какие возможности это открывает по расширению ваших операционных сервисов

AZ

если невозможно - складывайте в объектный стор и напишите честный snapshot builder как у всех остальных CDC

SS

если невозможно - складывайте в объектный стор и напишите честный snapshot builder как у всех остальных CDC

я не очень умный... раскройте, пожалуйста, суть "честного snapshot builder"?

AZ

я не очень умный... раскройте, пожалуйста, суть "честного snapshot builder"?

вы складываете изменения к таблице в датасет, пишете джоб который принимает предыдущий снапшот таблицы на вход и применяет изменения к этому снапшоту и пишете новый

АА

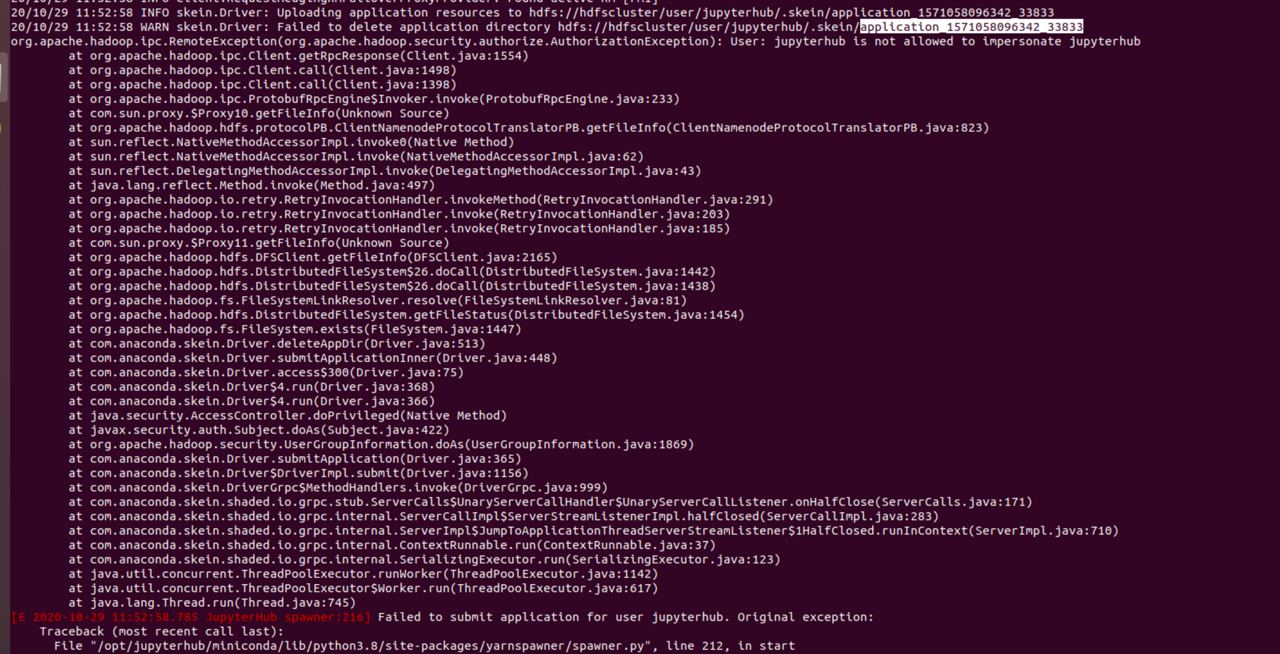

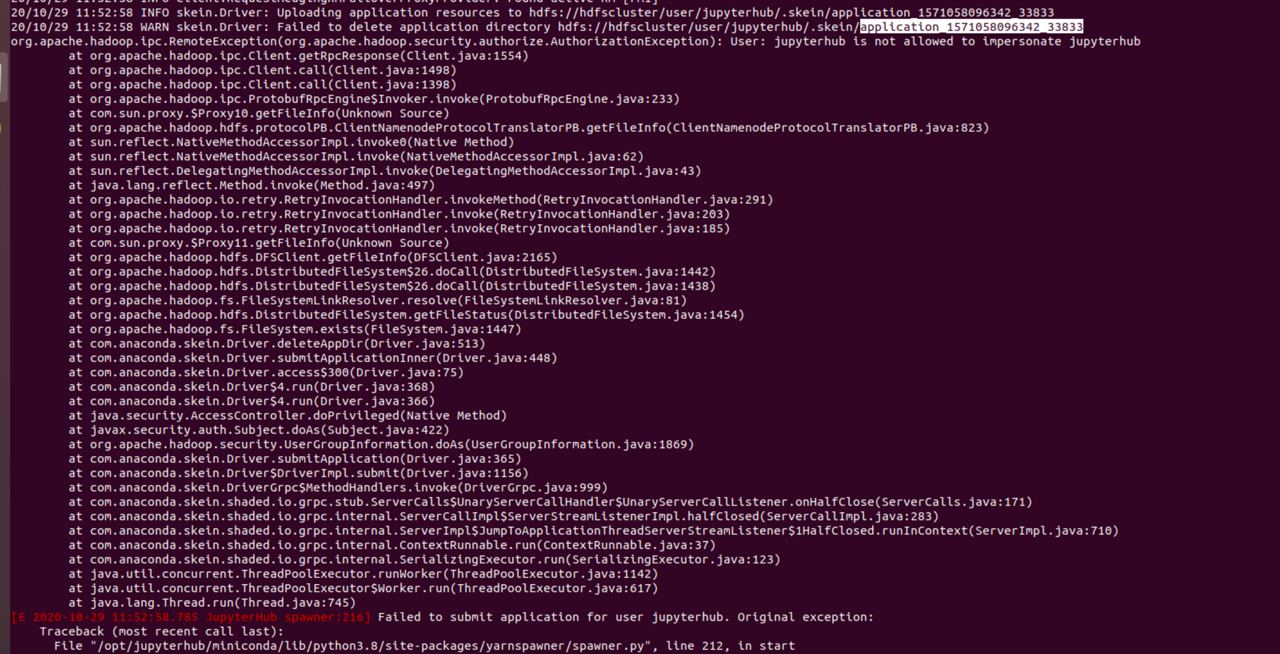

@dartov вот такая сейчас ошибка, в core-site.xml я добавил следующие:

и сделал hdfs dfsadmin -refreshNodes

<property>

<name>hadoop.proxyuser.jupyterhub.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.jupyterhub.groups</name>

<value>*</value>

</property>

и сделал hdfs dfsadmin -refreshNodes

AZ

@dartov вот такая сейчас ошибка, в core-site.xml я добавил следующие:

и сделал hdfs dfsadmin -refreshNodes

<property>

<name>hadoop.proxyuser.jupyterhub.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.jupyterhub.groups</name>

<value>*</value>

</property>

и сделал hdfs dfsadmin -refreshNodes

надо делать refreshNamenodes, и вообще вроде был скрипт sbin/refresh-namenodes.sh где-то в ванильке

АА

я правильно понимаю он не подхватывает конфиг

AZ

ну и проверьте что изменения в core-site разъехались по всем нодам

АА

а вот идиотский вопрос, как глянуть на каком порту работает хадуп netstat не предлогать

AZ

хадуп работает на куче портов

AZ

какой сервис?