DZ

Size: a a a

2020 September 18

переписать XGBoost на SQL, и всем будет удобно!

Я собесил чувака который перспетроны на скл писал

AZ

Oleksandr Averchenko

Как два пальца об асфальт.

ну или можно просто попросить СУБД запустить питон или что там

AE

Oleksandr Averchenko

И фронтенд тоже.

я видел такую систему в эксплуатации. от ingest'а сырых данных до рассылки писем клиентам ВСЁ НА PL/SQL

AE

меня наняли, чтобы сделать к неё отдельно стоящий фронт. делал два года. потом контора сдохла.

AE

хм. посмотрел. а всего-то 362 хранимки. не так и много, и почему я эту лапшу почти год распутывал...

МС

Всем привет! Коллеги, подскажите в чем проблема. Испульзую спарк стриминг для чтения из кафки, однако он выводит только первое сообщение, а остальные нет

spark = SparkSession \

.builder \

.appName('Test') \

.getOrCreate()

lines = spark \

.readStream \

.format("kafka") \

.option("kafka.bootstrap.servers", "10.1.25.111:9092, 10.1.25.112:9092, 10.1.25.113:9092") \

.option("subscribe", "dev.etl.fts-ftp.agr2") \

.option('startingOffsets', 'earliest') \

.load()

lines \

.selectExpr("CAST(key AS STRING)", "CAST(value AS STRING)") \

.writeStream \

.format("console") \

.start() \

.awaitTermination()

VP

Всем привет! Коллеги, подскажите в чем проблема. Испульзую спарк стриминг для чтения из кафки, однако он выводит только первое сообщение, а остальные нет

spark = SparkSession \

.builder \

.appName('Test') \

.getOrCreate()

lines = spark \

.readStream \

.format("kafka") \

.option("kafka.bootstrap.servers", "10.1.25.111:9092, 10.1.25.112:9092, 10.1.25.113:9092") \

.option("subscribe", "dev.etl.fts-ftp.agr2") \

.option('startingOffsets', 'earliest') \

.load()

lines \

.selectExpr("CAST(key AS STRING)", "CAST(value AS STRING)") \

.writeStream \

.format("console") \

.start() \

.awaitTermination()

Передай Паше Кащенко привет))

Узнал по IP)

Узнал по IP)

PK

передал, спасибо )

PK

Тебе тож привет )

VP

Попробуй offset убрать

МС

Попробуй offset убрать

результат тот же

K

Пошли после митапа

DZ

Пошли

DZ

Можно вместо

А

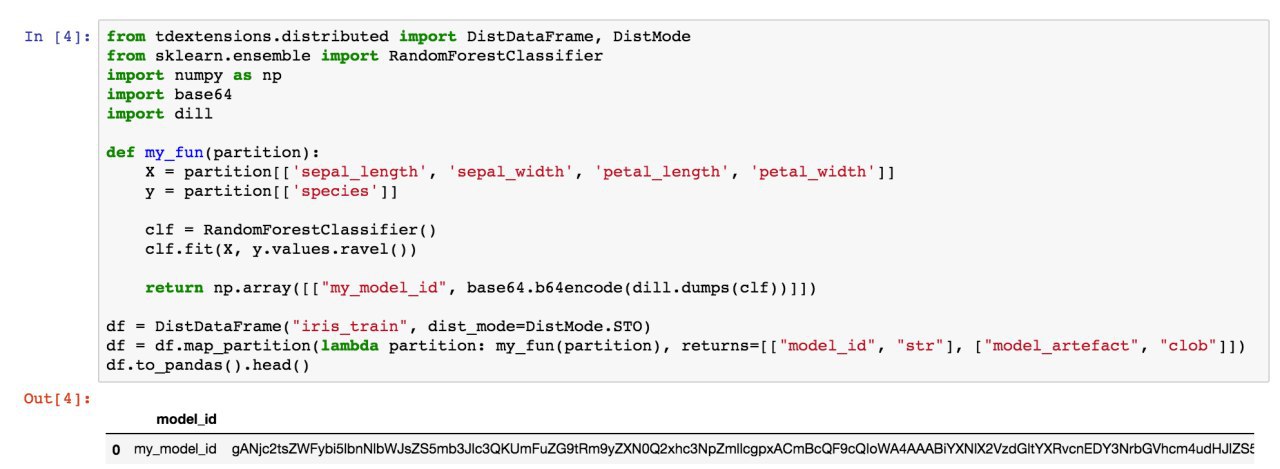

в чем проблема писать мл на oracle, он все умеет) http://blog.skahin.ru/2020/03/oracle-dataminer-ml-python-sklearn.html

OA

в чем проблема писать мл на oracle, он все умеет) http://blog.skahin.ru/2020/03/oracle-dataminer-ml-python-sklearn.html

mssql тоже умеет

2020 September 19

ME

Ох, реклама прям в нике)

RK

Ох, реклама прям в нике)

Не спорю. Но и не во вред здешнему народу :)

2020 September 20

SD

Всем привет. Ребят, подскажите, пожалуйста. Работаю интерактивно со spark-shell. Команды типа explain или sc.getConf.getAll выводят ограниченное кол-во строк. Нагуглил spark.debug.maxToStringFields, но установка этого параметра ничего не меняет. Как увидеть полный вывод?