AT

Size: a a a

2020 September 15

если совсем плохо, лучше к чародеям и гадалкам)

Сейчас модно говорить к subject matter expert

Ж

кстати если кому надо строить PMML pipeline то теперь по крайней мере для скоринга есть PMML4S с лицензией Apache, если вы пишете коммерческий софт с закрытым кодом - то можно не платить Виллу)

PMML file создал. Вроде по данным в нем pipeline смог заменить missing values на те, что прописаны в аргументе (заменяю на самое частое встречающееся значение). Мои версии:

Ж

python: 3.6.8

sklearn: 0.21.3

sklearn2pmml: 0.49.0

joblib: 0.14.1

sklearn_pandas: 1.8.0

pandas: 1.1.1

numpy: 1.19.1

xgboost 0.90

sklearn: 0.21.3

sklearn2pmml: 0.49.0

joblib: 0.14.1

sklearn_pandas: 1.8.0

pandas: 1.1.1

numpy: 1.19.1

xgboost 0.90

SS

коллеги, привет!

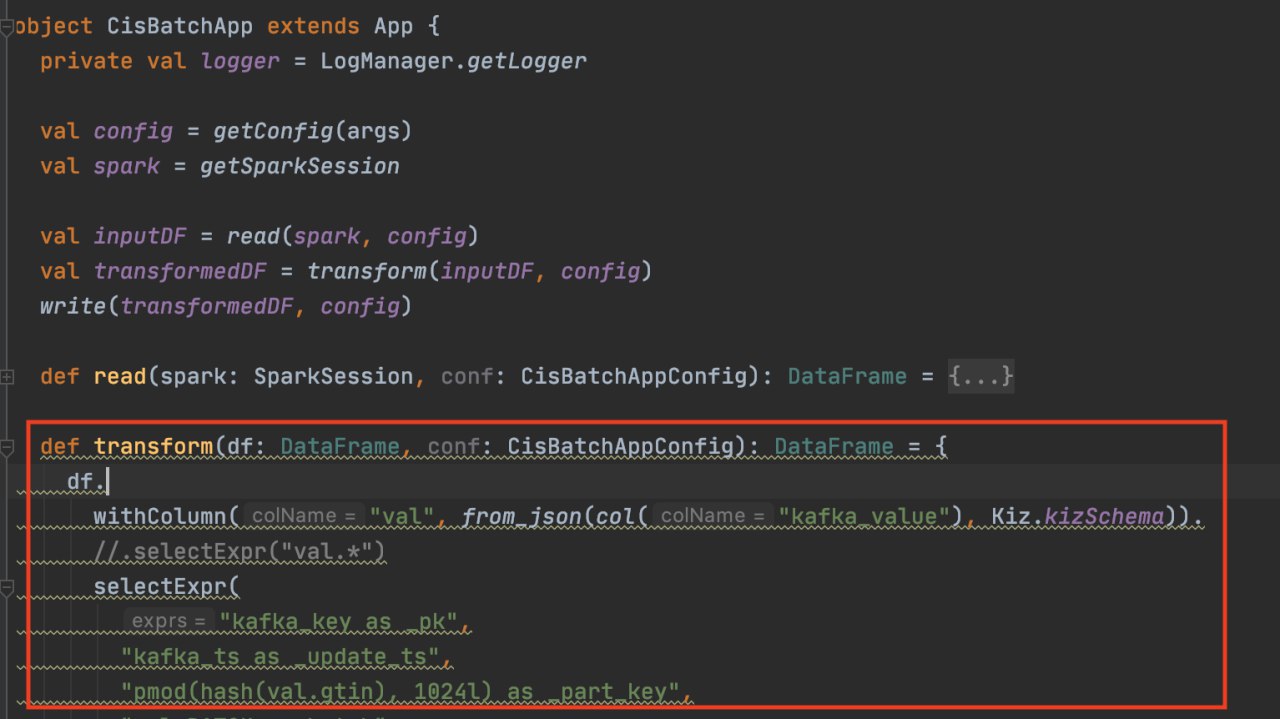

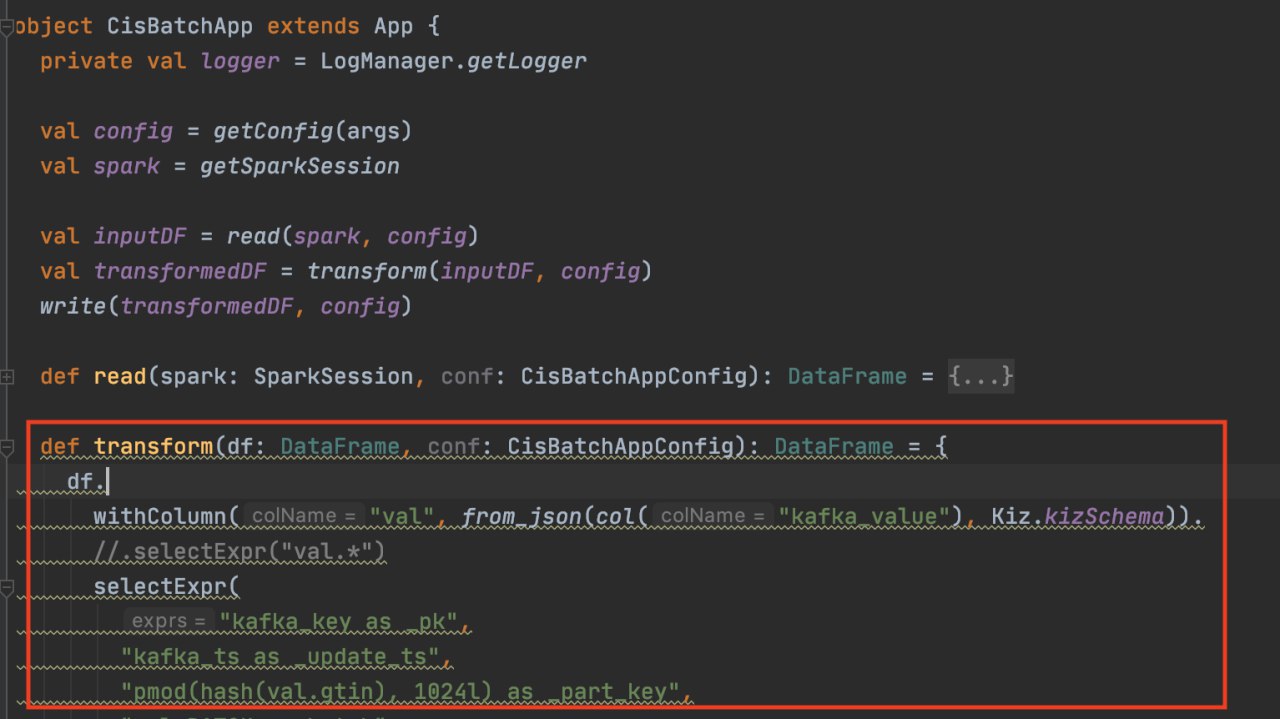

подскажите как вы делаете юнит-тесты для трансформаций SparkSQL?

подскажите как вы делаете юнит-тесты для трансформаций SparkSQL?

DZ

коллеги, привет!

подскажите как вы делаете юнит-тесты для трансформаций SparkSQL?

подскажите как вы делаете юнит-тесты для трансформаций SparkSQL?

Как любые юнит тесты

DZ

Можно holdenkarau testkit взять

DZ

коллеги, привет!

подскажите как вы делаете юнит-тесты для трансформаций SparkSQL?

подскажите как вы делаете юнит-тесты для трансформаций SparkSQL?

А в чем конкретно сложность?

SS

А в чем конкретно сложность?

у меня есть функция transform, которая парсит схему данных в исходном DF с json-ом внутри. как мне правильно покрыть эту функцию тестами?

N

подсунуть пустой конф, неправильный конф, неполный конф, конф с нуллами.

подсунуть null df, df с неправильной схемой, df с правильной схемой.

подсунуть null df, df с неправильной схемой, df с правильной схемой.

SS

подсунуть пустой конф, неправильный конф, неполный конф, конф с нуллами.

подсунуть null df, df с неправильной схемой, df с правильной схемой.

подсунуть null df, df с неправильной схемой, df с правильной схемой.

подсунуть пустой конф, неправильный конф, неполный конф, конф с нуллами. - это юнит-тесты функции getConfig

SS

у меня сейчас портянка SparkSQL кода, трансформирующего с помощью встроенных функций SparkSQL исходный датафрейм в нужный

SS

мне либо проверять все возможные комбинации в исходном датафрейме (и жисоне внутри него),

либо делать цепочку трансформаций через Spark DSL:

withColumn("newCol1", my_transform_func1(col("oldCol1"))).

withColumn("newCol2", my_transform_func2(col("oldCol2"))).

и покрывать тестами все эти my_transform_funcN ?

либо делать цепочку трансформаций через Spark DSL:

withColumn("newCol1", my_transform_func1(col("oldCol1"))).

withColumn("newCol2", my_transform_func2(col("oldCol2"))).

и покрывать тестами все эти my_transform_funcN ?

DZ

подсунуть пустой конф, неправильный конф, неполный конф, конф с нуллами.

подсунуть null df, df с неправильной схемой, df с правильной схемой.

подсунуть null df, df с неправильной схемой, df с правильной схемой.

Ну хз, имхо разрабы должны тестировать только позитивные кейсы

DZ

у меня есть функция transform, которая парсит схему данных в исходном DF с json-ом внутри. как мне правильно покрыть эту функцию тестами?

Я бы просто для начала использовал датасет

DZ

На вход дал что-то тривиальное, на выходе ждал дф нужной длины с нужными значениями

R

Всем привет, подскажите пожалуйста, какие бест пректизы с использованием спарка и эйрфлоу. Нужно ручками собирать джарник и подсовывать или есть какие-то более изящные решения?

SS

Всем привет, подскажите пожалуйста, какие бест пректизы с использованием спарка и эйрфлоу. Нужно ручками собирать джарник и подсовывать или есть какие-то более изящные решения?

оО... тоже интересует правильный ответ на этот вопрос!

S

а он есть?

S

прямо 42 запахло :)

SS

(мы сейчас дойдем и до иллюзорности бытия! докажи с помощтю Спарка, что наш мир = матрица)