IG

Size: a a a

2020 July 08

AlКо

Борщевик в два моих роста

У нас он есть оказывается, не знал. У вас его проходят по ТБ?

КФ

Сравните

КФ

Ущерб в 148 миллиардов

Росприроднадзор оценил экологический ущерб от разлива нефтепродуктов в Норильске в 148 млрд рублей. Об этом говорится в сообщении ведомства.

Ведомство отметило, что уже направило требования о добровольном возмещении ущерба в Норильско-Таймырскую энергетическую компанию, входящую в группу «Норникель».

В самом «Норникеле» «Интерфаксу» пояснили, что документы пока не получали и пообещали прокомментировать их после их поступления.

Чистая прибыль «Норникеля» за 2019 год составила 6 млрд долларов (430 млрд рублей).

В результате аварии вылилась 21т тонн нефтепродуктов. Это крупнейшая авария в истории России после разлива 94т тонн нефти в Коми в 1994 году.

What’s Your Emergency❓

Росприроднадзор оценил экологический ущерб от разлива нефтепродуктов в Норильске в 148 млрд рублей. Об этом говорится в сообщении ведомства.

Ведомство отметило, что уже направило требования о добровольном возмещении ущерба в Норильско-Таймырскую энергетическую компанию, входящую в группу «Норникель».

В самом «Норникеле» «Интерфаксу» пояснили, что документы пока не получали и пообещали прокомментировать их после их поступления.

Чистая прибыль «Норникеля» за 2019 год составила 6 млрд долларов (430 млрд рублей).

В результате аварии вылилась 21т тонн нефтепродуктов. Это крупнейшая авария в истории России после разлива 94т тонн нефти в Коми в 1994 году.

What’s Your Emergency❓

КФ

Сравните было-стало. Все вымерло до песка 😰

КФ

Ущерб в 148 миллиардов

Росприроднадзор оценил экологический ущерб от разлива нефтепродуктов в Норильске в 148 млрд рублей. Об этом говорится в сообщении ведомства.

Ведомство отметило, что уже направило требования о добровольном возмещении ущерба в Норильско-Таймырскую энергетическую компанию, входящую в группу «Норникель».

В самом «Норникеле» «Интерфаксу» пояснили, что документы пока не получали и пообещали прокомментировать их после их поступления.

Чистая прибыль «Норникеля» за 2019 год составила 6 млрд долларов (430 млрд рублей).

В результате аварии вылилась 21т тонн нефтепродуктов. Это крупнейшая авария в истории России после разлива 94т тонн нефти в Коми в 1994 году.

What’s Your Emergency❓

Росприроднадзор оценил экологический ущерб от разлива нефтепродуктов в Норильске в 148 млрд рублей. Об этом говорится в сообщении ведомства.

Ведомство отметило, что уже направило требования о добровольном возмещении ущерба в Норильско-Таймырскую энергетическую компанию, входящую в группу «Норникель».

В самом «Норникеле» «Интерфаксу» пояснили, что документы пока не получали и пообещали прокомментировать их после их поступления.

Чистая прибыль «Норникеля» за 2019 год составила 6 млрд долларов (430 млрд рублей).

В результате аварии вылилась 21т тонн нефтепродуктов. Это крупнейшая авария в истории России после разлива 94т тонн нефти в Коми в 1994 году.

What’s Your Emergency❓

AL

Сравните было-стало. Все вымерло до песка 😰

но это же Норильск. я там бываю каждый год и, поверьте, там все уже давно очень плохо. Просто сейчас из-за последней аварии об этом заговорили по всей стране. а так - вода в Далдыкане приобретает такой цвет почти каждый год, погуглите фотки. Обычно это объясняли "аномальными дождями"). Да и сброс отходов в Пясино, который недавно "открыли", тоже вряд ли только сейчас начался

A

У нас он есть оказывается, не знал. У вас его проходят по ТБ?

Проходят

КФ

но это же Норильск. я там бываю каждый год и, поверьте, там все уже давно очень плохо. Просто сейчас из-за последней аварии об этом заговорили по всей стране. а так - вода в Далдыкане приобретает такой цвет почти каждый год, погуглите фотки. Обычно это объясняли "аномальными дождями"). Да и сброс отходов в Пясино, который недавно "открыли", тоже вряд ли только сейчас начался

А никто и не говорит что это только сейчас. Как раз наоборот. Масштабы трэша осознаваемы. То, что он замылился у некоторых, притерпелся, ничего не отменяет.

SW

Видео от Deepfakes теперь можно защищать🔥

Ребята из Бостонского университета разработали алгоритм, позволяющий защитить изображения от использования в качестве основы дипфейков.

Алгоритм накладывает на изображение или видео невидимый фильтр, и если кто-то попытается использовать нейронную сеть для модификации этих файлов, они либо останутся без изменений, либо станут полностью искаженными - фильтр изменяет пиксели таким образом, что видео и изображения становятся непригодными для изготовления дипфейков.

Исходный код доступен всем желающим.👻

А тутЬ есть видео демонстрирующее работу

===============

Не исключено что подобные технологии со временем будут интегрированы в приложения

Забавно теперь это похоже на еще одну маленькую войну. Одни создают Deepfakes, другие ломают.

Ребята из Бостонского университета разработали алгоритм, позволяющий защитить изображения от использования в качестве основы дипфейков.

Алгоритм накладывает на изображение или видео невидимый фильтр, и если кто-то попытается использовать нейронную сеть для модификации этих файлов, они либо останутся без изменений, либо станут полностью искаженными - фильтр изменяет пиксели таким образом, что видео и изображения становятся непригодными для изготовления дипфейков.

Исходный код доступен всем желающим.👻

А тутЬ есть видео демонстрирующее работу

===============

Не исключено что подобные технологии со временем будут интегрированы в приложения

Забавно теперь это похоже на еще одну маленькую войну. Одни создают Deepfakes, другие ломают.

2020 July 09

КФ

Песня про камушки

КФ

КФ

Вот те слова, которые я так искала для описания тотального 2020: поехал илюхин дом!!!

КФ

КФ

два питекантропа обнявшись

доели забродивший фрукт

и штож ты вьёшься птеродактиль

орут

© [id62713287|икигаев]

доели забродивший фрукт

и штож ты вьёшься птеродактиль

орут

© [id62713287|икигаев]

D

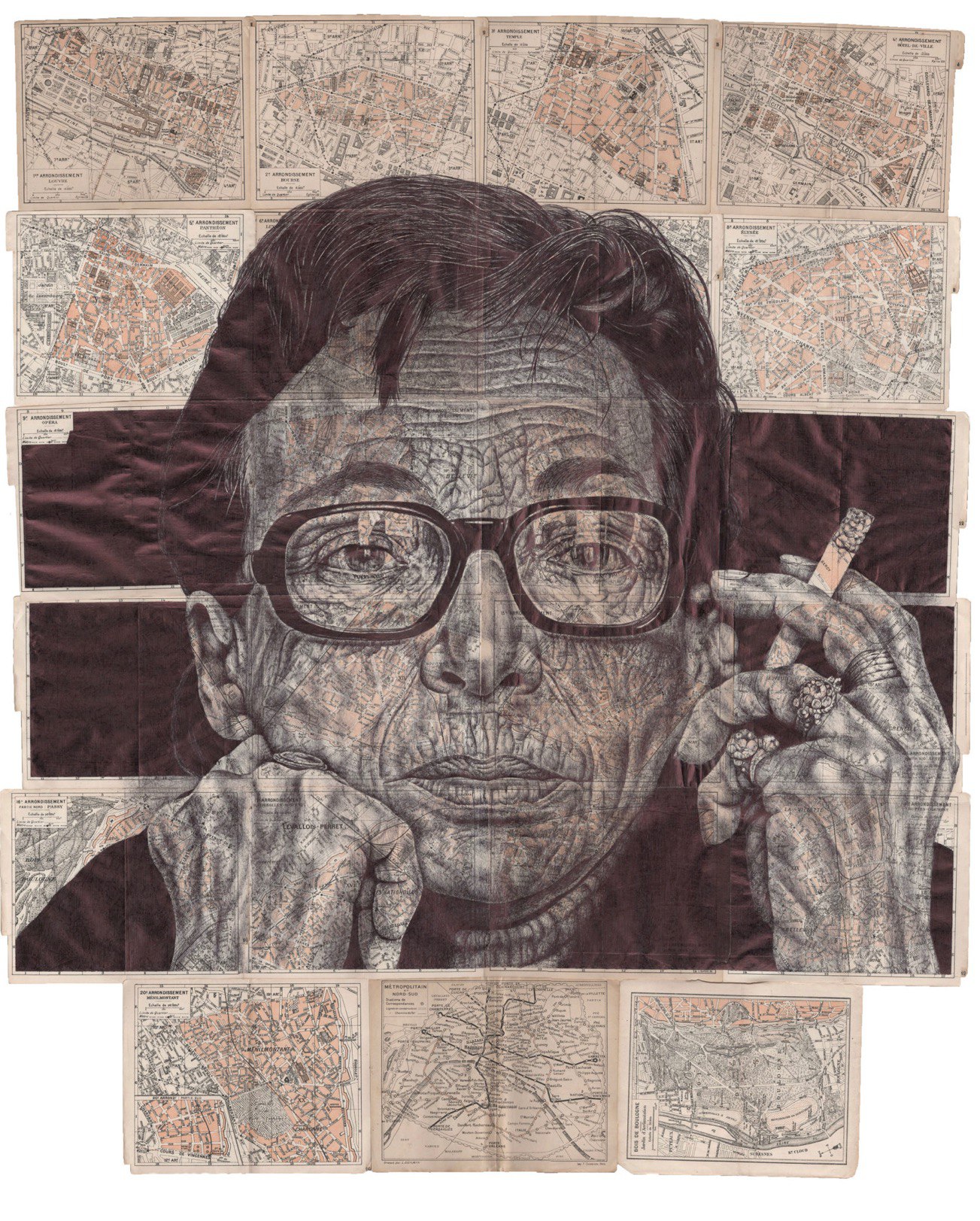

Карты как искусство. Портреты шариковой ручкой

Рисунки шариковой ручкой британского художника Марка Пауэлла гипнотичны в их необычайных деталях, а применение обычного инструмента придает его работе простоту и в то же время глубокое содержание, обогащая карты новыми текстурами.

Собрали для вас подборку работ Марка Пауэлла на старых географических картах.

Рисунки шариковой ручкой британского художника Марка Пауэлла гипнотичны в их необычайных деталях, а применение обычного инструмента придает его работе простоту и в то же время глубокое содержание, обогащая карты новыми текстурами.

Собрали для вас подборку работ Марка Пауэлла на старых географических картах.

NK

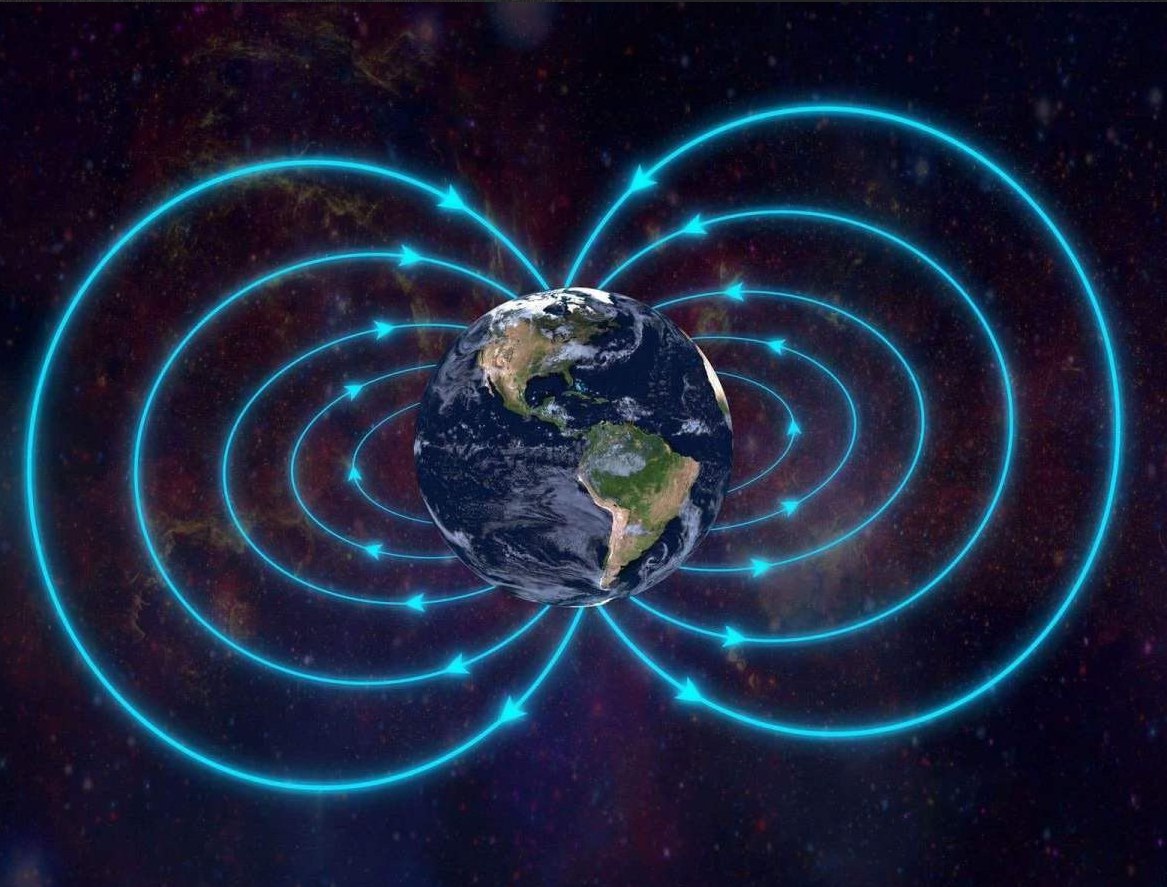

Минутка магнетизма

Эдакая полуновость о магнитном поле Земли. Просто, чтобы вы знали, что там что-то происходит.

geologika-web.ru/ten_times_faster

🕓 1,5 мин.

Эдакая полуновость о магнитном поле Земли. Просто, чтобы вы знали, что там что-то происходит.

geologika-web.ru/ten_times_faster

🕓 1,5 мин.

2020 July 10

КФ

Магнитный пупочек 😊 ишь ты

AI

Магнитный пупочек 😊 ишь ты

R

Похож. Колбаса видимо всосалась.

КФ

Легендарный Акватилис (Семенов!) теперь в телеге!

https://t.me/Aquatilis

https://t.me/Aquatilis