Size: a a a

2021 March 04

Виды на город и Tai Mo Shan

Когда сделаю сайт (по которому прогресса с последних обновлений нет), на нем будет ссылка на гугл-фото с хайрезами. Они значительно лучше сжатых телеграмом версий выглядят.

2021 March 08

I hate Mondays. Maybe.

Достал свой долго-не-трогаемый Switch, пересоздал остров в Animal Crossing, наконец-то попробовал Splatoon 2 который у меня очень давно лежал. Музычка приятная как минимум. Свитч прикольная тема на самом деле, и игры все делаются на него под строго определенные требования (ну, собственно как и для любой консоли), но вот как долго иногда идут загрузки и какой маленький у него экран иногда, это да....

Вроде в этом году то ли объявят, то ли выйдет новый Switch. Несмотря на странную политику Nintendo, я уже определенно хочу его купить.

Мне кажется что это будет как с Dell XPS 13, где Dell пошагово улучшали ноут, конечно не без ошибок, но зато в итоге у них получилась просто конфетка (еще бы проц от AMD...)

Вроде в этом году то ли объявят, то ли выйдет новый Switch. Несмотря на странную политику Nintendo, я уже определенно хочу его купить.

Мне кажется что это будет как с Dell XPS 13, где Dell пошагово улучшали ноут, конечно не без ошибок, но зато в итоге у них получилась просто конфетка (еще бы проц от AMD...)

2021 March 09

Пытаюсь заниматься сайтом, а получаются занятия страданиями. Зато интересно. И, кажется, я знаю, какой будет первый материал на сайте — как раз о том как я все настраивал. Если, конечно, это когда-нибудь завершится.

Сам репозиторий я публичным делать не хочу по единственной причине — контент сайта тоже хранится в нем, мне не хочется чтобы можно было лезть в старые версии постов. Может стоит разделить его на два репозитория...? Я об этом подумаю. Вообще хорошо бы сделать такое как можно раньше чтобы потом меньше истории из гита вычищать, но посмотрим.

Сейчас я на этапе деплоя сижу. Контейнер уже успешно собирается с помощью buildah (правда я не проверил, работает ли он), kubernetes (k3s) уже давным-давно более-менее крутится. Вот только k3s чето не видит контейнеры которые были собраны локально. Уф, уже больше часа над этим бьюсь 🤯.

Потом, как с этим разберусь и запишу себе в файлик как я умудрился, надо будет немного почистить контент на сайте. Затем надо будет писать hook для автодеплоя сайта, который будет крутиться в том же kubernetes. Когда-нибудь совсем в далеком будущем надо будет поработать с уменьшением поверхности возможных атак, вырезая использование root где его можно не использовать.

Когда я занимаюсь такой жутью, всегда помню что рано или поздно мне придется все деплоить заново, например на другой машине. Ну или, в публичных проектах, будут новички которые не знают что с этим делать. Поэтому стараюсь автоматизировать вещи которые нужно делать регулярно, а нерегулярные — хотя бы документировать.

Больше всего таких заметок получается про начальную настройку всяких ужасов типа кубернетес. Например, так как я его ставлю поверх btrfs, kubelet'у требуется специальный bind mount потому что он недостаточно умный. Такие дела.

🥳

Сам репозиторий я публичным делать не хочу по единственной причине — контент сайта тоже хранится в нем, мне не хочется чтобы можно было лезть в старые версии постов. Может стоит разделить его на два репозитория...? Я об этом подумаю. Вообще хорошо бы сделать такое как можно раньше чтобы потом меньше истории из гита вычищать, но посмотрим.

Сейчас я на этапе деплоя сижу. Контейнер уже успешно собирается с помощью buildah (правда я не проверил, работает ли он), kubernetes (k3s) уже давным-давно более-менее крутится. Вот только k3s чето не видит контейнеры которые были собраны локально. Уф, уже больше часа над этим бьюсь 🤯.

Потом, как с этим разберусь и запишу себе в файлик как я умудрился, надо будет немного почистить контент на сайте. Затем надо будет писать hook для автодеплоя сайта, который будет крутиться в том же kubernetes. Когда-нибудь совсем в далеком будущем надо будет поработать с уменьшением поверхности возможных атак, вырезая использование root где его можно не использовать.

Когда я занимаюсь такой жутью, всегда помню что рано или поздно мне придется все деплоить заново, например на другой машине. Ну или, в публичных проектах, будут новички которые не знают что с этим делать. Поэтому стараюсь автоматизировать вещи которые нужно делать регулярно, а нерегулярные — хотя бы документировать.

Больше всего таких заметок получается про начальную настройку всяких ужасов типа кубернетес. Например, так как я его ставлю поверх btrfs, kubelet'у требуется специальный bind mount потому что он недостаточно умный. Такие дела.

🥳

2021 March 10

Случайно замерил время от двери квартиры до двери офиса (пешком) — поставил музыку ровно когда вышел, и глянул на нее когда дошел до офиса.

...

...

4 минуты 15 секунд ± 10 секунд на лифты.

...

...

4 минуты 15 секунд ± 10 секунд на лифты.

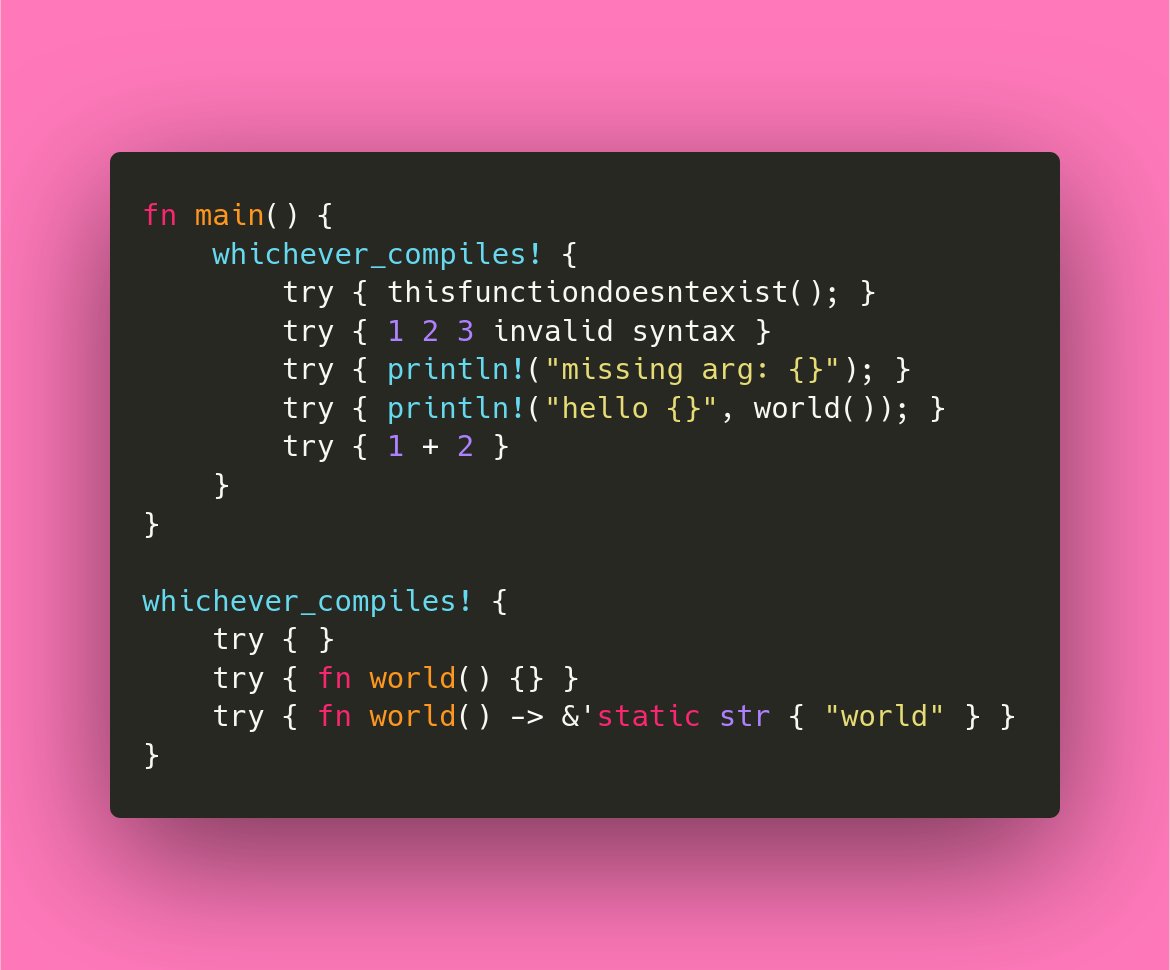

С одной стороны вроде велосипедится... С другой стороны, а чето и не знаю альтернатив, да и по сути кода не так много получится.

В общем пишу питон скрипт который может эту жуть деплоить. #dev

В общем пишу питон скрипт который может эту жуть деплоить. #dev

Расшифрую немного:

Не уверен что все это получится вместе заставить работать, но вроде проще сложно сделать. Если конечно не собирать контейнеры на хосте и вырезать registry, а так же сделать deployhook не контейнером. Но чтобы собирать на хосте надо запускать buildah от рута (и k3s все равно не увидит собранных контейнеров), либо пихать контейнеры в какой-то registry. А так будет крохотный private registry и сборка всего в контейнере. Которую потом еще можно будет превратить в не только Continuous Delivery, но и Continuous Integration запихнув в kubernetes runner если очень захочется.

🙈 #dev

gen, server, render — для отладки на локальной машине._k8s_ops — создает и запихивает в kubernetes два pod — registry и deployhook. При этом контейнер для второго собирается локально, запихивается в registry и потом уже используется в kubernetes._web — собирает сайт и создает контейнеры которые пихаются в вышеупомянутый registry. И исполнятся этот кусок будет внутри контейнера deployhook по триггеру с гитхаба._k8s_web — создает и запихивает pod с контейнерами nginx + certbot которые мы запихнули в registry на прошлом шаге. Да, исполняется тоже внутри deployhook.Не уверен что все это получится вместе заставить работать, но вроде проще сложно сделать. Если конечно не собирать контейнеры на хосте и вырезать registry, а так же сделать deployhook не контейнером. Но чтобы собирать на хосте надо запускать buildah от рута (и k3s все равно не увидит собранных контейнеров), либо пихать контейнеры в какой-то registry. А так будет крохотный private registry и сборка всего в контейнере. Которую потом еще можно будет превратить в не только Continuous Delivery, но и Continuous Integration запихнув в kubernetes runner если очень захочется.

🙈 #dev

ftvkyo2011

Расшифрую немного:

Не уверен что все это получится вместе заставить работать, но вроде проще сложно сделать. Если конечно не собирать контейнеры на хосте и вырезать registry, а так же сделать deployhook не контейнером. Но чтобы собирать на хосте надо запускать buildah от рута (и k3s все равно не увидит собранных контейнеров), либо пихать контейнеры в какой-то registry. А так будет крохотный private registry и сборка всего в контейнере. Которую потом еще можно будет превратить в не только Continuous Delivery, но и Continuous Integration запихнув в kubernetes runner если очень захочется.

🙈 #dev

gen, server, render — для отладки на локальной машине._k8s_ops — создает и запихивает в kubernetes два pod — registry и deployhook. При этом контейнер для второго собирается локально, запихивается в registry и потом уже используется в kubernetes._web — собирает сайт и создает контейнеры которые пихаются в вышеупомянутый registry. И исполнятся этот кусок будет внутри контейнера deployhook по триггеру с гитхаба._k8s_web — создает и запихивает pod с контейнерами nginx + certbot которые мы запихнули в registry на прошлом шаге. Да, исполняется тоже внутри deployhook.Не уверен что все это получится вместе заставить работать, но вроде проще сложно сделать. Если конечно не собирать контейнеры на хосте и вырезать registry, а так же сделать deployhook не контейнером. Но чтобы собирать на хосте надо запускать buildah от рута (и k3s все равно не увидит собранных контейнеров), либо пихать контейнеры в какой-то registry. А так будет крохотный private registry и сборка всего в контейнере. Которую потом еще можно будет превратить в не только Continuous Delivery, но и Continuous Integration запихнув в kubernetes runner если очень захочется.

🙈 #dev

Где-то я это уже видел... Но это ладно. В этот раз будет еще лучше.

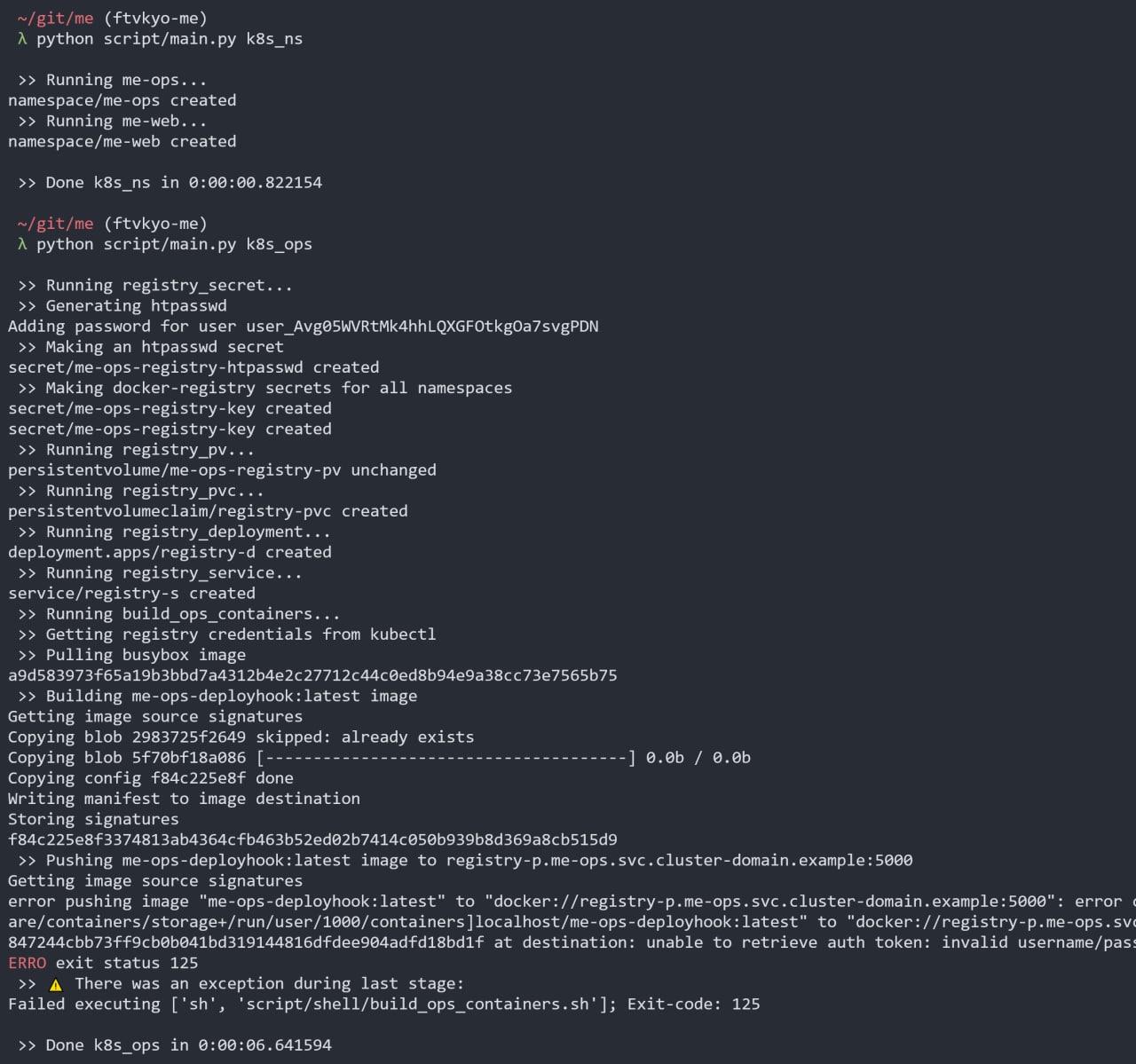

Почти закончил автодеплой registry и запихивания в него контейнеров. Строчки начинающиеся с

Ошибка внизу — чето не работают логин и пароль. Ну, буду искать как чинить. Надеюсь это значит что и правда логин и пароль неверны, а не неудачное подключение.

#dev

" >> " это мои логи, можно увидеть какие этапы деплоя есть.Ошибка внизу — чето не работают логин и пароль. Ну, буду искать как чинить. Надеюсь это значит что и правда логин и пароль неверны, а не неудачное подключение.

#dev