Сегодняшняя статья:

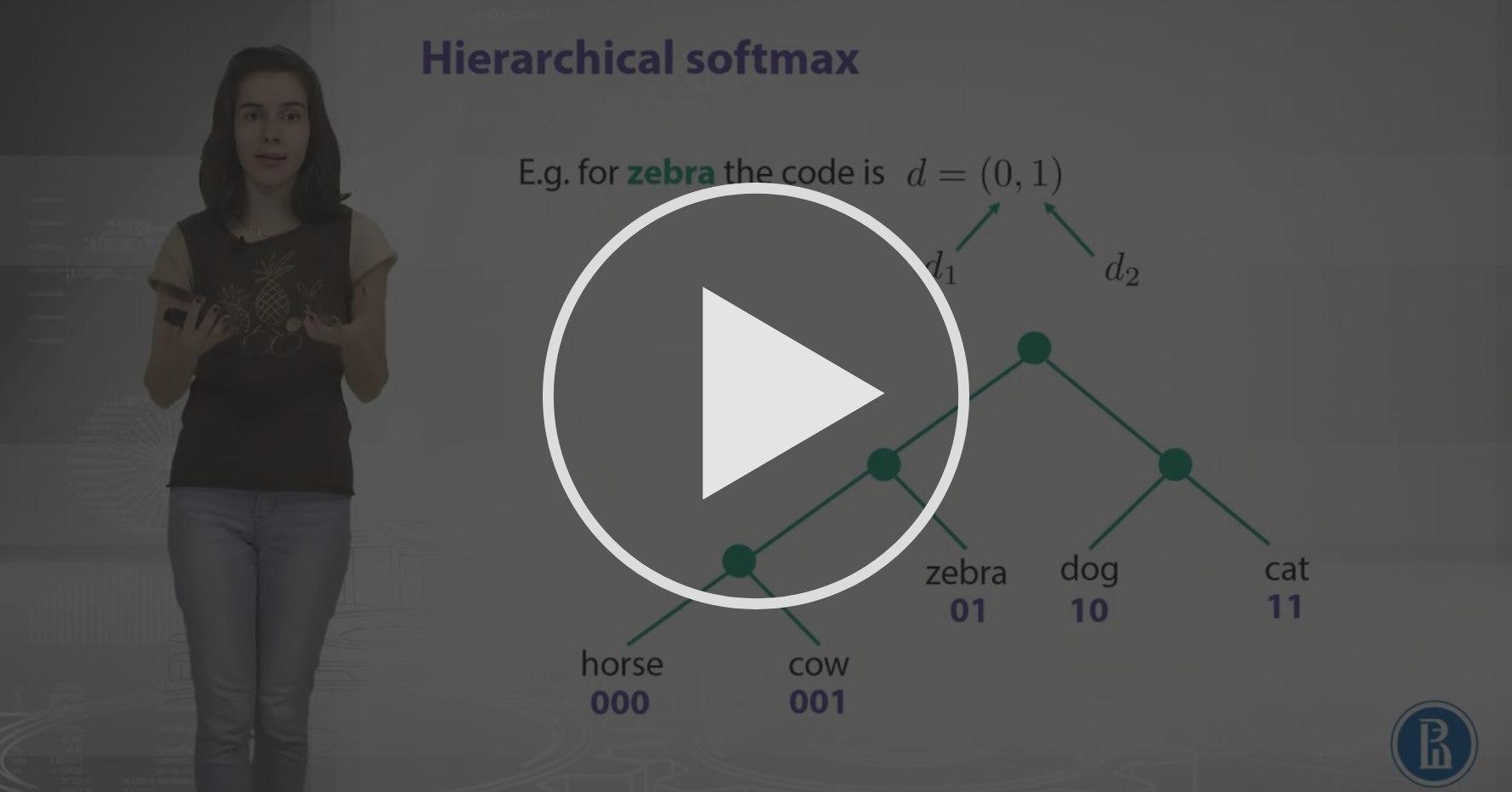

Enriching Word Vectors with Subword Information

Piotr Bojanowski, Edouard Grave, Armand Joulin and Tomas Mikolov

https://arxiv.org/pdf/1607.04606.pdfВ статье представлен метод получения векторных представлений

fastText, который избавлен от одной из больших проблем классического word2vec: невозможности получения векторов для слов, отсутствующих в обучающей выборке (out-of-vocabulary words). Основная идея в том, чтобы использовать для построения эмбеддинга char n-gram.

На самом деле в своей практике я (и не только я) использую предобученный fastText заметно чаще, чем предобученный классический w2v / GloVe, поэтому считаю эту статью очень важной. К сожалению, она вышла уже после записи стэнфордских видео, поэтому про них ничего не рассказано, но мы

обязательно затронем этот алгоритм на семинаре.

Дополнительные ссылки:

https://fasttext.cc - офсайт

https://youtu.be/CHcExDsDeHU - видео с презентацией статьи

https://github.com/facebookresearch/fastText/blob/master/pretrained-vectors.md - бинарники готовых векторов, обученных на википедии для

294 языков