Ю

Size: a a a

2020 June 02

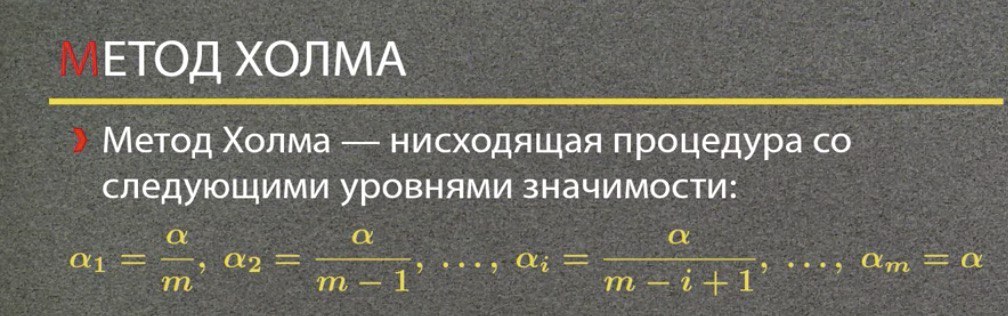

Прошу прощения, значит для первой гипотезы

Ю

Но тогда alpha/N это же получается очень маленькое число? разве нет?

Это плата за уверенность о доле ошибок первого рода при таком количестве проверок. Там совсем мало гипотез вроде будет отвергнуто (возможно, 0, точно не помню)

2020 June 03

ЯШ

Зато бесплатно

TA

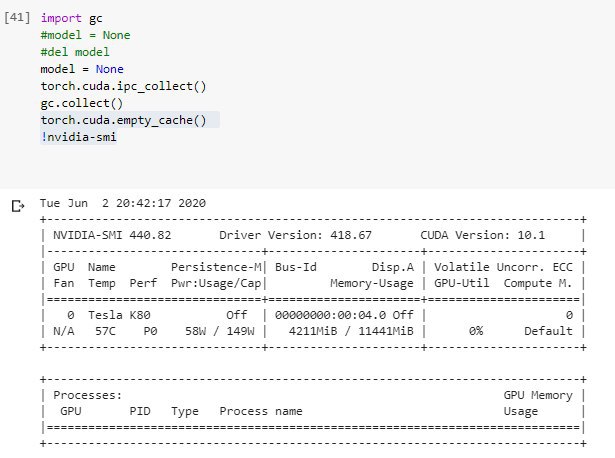

Подскажите кто знает очистить память на колабе у куда?я попробовал вот так но не выходит

AR

#C6W3 Анализ тональности текста

Это вопрос больше про типовую задачу классического ML с kaggle. Допустим, нам дали обучающую выборку с классами и тестовую без классов. Чтобы избежать переобучения, мы используем кросс валидацию на обучающей выборке. Согласно некоторой метрике (в рамках этой задачи accuracy) получаем самую лучшую модель, выбранную с помощью grid search и/или личных соображений/предпочтений. Чем больше качество на обучающей под вышеуказанному алгоритму, тем лучше оценка на тестовой выборке - по крайней мере после нескольких моих самбитов зависимость виднеется. Правильно ли я рассуждаю?

Это вопрос больше про типовую задачу классического ML с kaggle. Допустим, нам дали обучающую выборку с классами и тестовую без классов. Чтобы избежать переобучения, мы используем кросс валидацию на обучающей выборке. Согласно некоторой метрике (в рамках этой задачи accuracy) получаем самую лучшую модель, выбранную с помощью grid search и/или личных соображений/предпочтений. Чем больше качество на обучающей под вышеуказанному алгоритму, тем лучше оценка на тестовой выборке - по крайней мере после нескольких моих самбитов зависимость виднеется. Правильно ли я рассуждаю?

AT

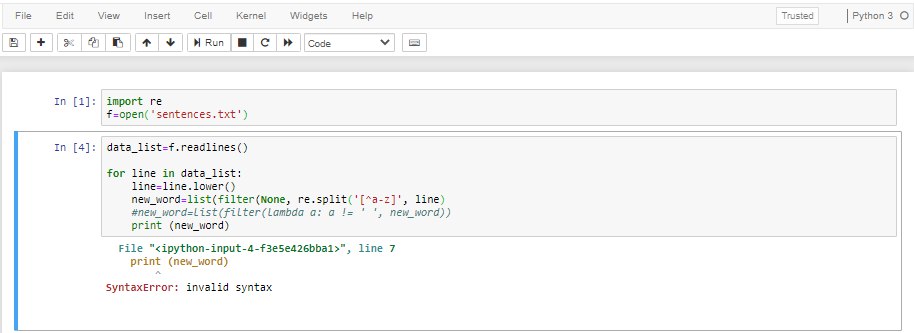

всем привет! #C1W2

Подскажите, пожалуйста, где ошибка?

Подскажите, пожалуйста, где ошибка?

IK

пробел в print

Ю

Третья строка снизу - не хватает закрывающей скобки

Ю

Даже двух вроде

AT

Третья строка снизу - не хватает закрывающей скобки

точно! спасибо!

I

#C6W3 Анализ тональности текста

Это вопрос больше про типовую задачу классического ML с kaggle. Допустим, нам дали обучающую выборку с классами и тестовую без классов. Чтобы избежать переобучения, мы используем кросс валидацию на обучающей выборке. Согласно некоторой метрике (в рамках этой задачи accuracy) получаем самую лучшую модель, выбранную с помощью grid search и/или личных соображений/предпочтений. Чем больше качество на обучающей под вышеуказанному алгоритму, тем лучше оценка на тестовой выборке - по крайней мере после нескольких моих самбитов зависимость виднеется. Правильно ли я рассуждаю?

Это вопрос больше про типовую задачу классического ML с kaggle. Допустим, нам дали обучающую выборку с классами и тестовую без классов. Чтобы избежать переобучения, мы используем кросс валидацию на обучающей выборке. Согласно некоторой метрике (в рамках этой задачи accuracy) получаем самую лучшую модель, выбранную с помощью grid search и/или личных соображений/предпочтений. Чем больше качество на обучающей под вышеуказанному алгоритму, тем лучше оценка на тестовой выборке - по крайней мере после нескольких моих самбитов зависимость виднеется. Правильно ли я рассуждаю?

по идее так и должно быть, потому что при кросс валидации, те данные на которых тестируется алгоритм не входят в обучение, но на практике, если например на ваши конечные признаки в тестовой выборке что то влияет, что не было учтено при составлении обучаемой выборки. могут быть расхождения

AR

Ibp

по идее так и должно быть, потому что при кросс валидации, те данные на которых тестируется алгоритм не входят в обучение, но на практике, если например на ваши конечные признаки в тестовой выборке что то влияет, что не было учтено при составлении обучаемой выборки. могут быть расхождения

Вот-вот, из-за этого это задание мне и кажется немного игрой вслепую - об особенностях тестовой ничего не знаем)

I

ну если вы ее сами создавали а потом просто отделили от общей кучи, то волноваться не очем

K

Вот-вот, из-за этого это задание мне и кажется немного игрой вслепую - об особенностях тестовой ничего не знаем)

Adversarial validation проведите

A

так в реальной жизни же так же

A

никогда нельзя быть увереным, что новые данные не окажутся под влиянием еще неизведанного фактора

KK

Привет, проверьте мою работу пожалуйста кто-то, я штук 5 чьих-то проверила вчера, а моя еще висит… https://www.coursera.org/learn/mathematics-and-python/peer/2yTvX/ustanovka-python/review/io6oAqQ4Eeq5Xw5LclVH6w

спасибо тому, кто отозвался и проверил)

АП

С4W1 Test Доверительные интервалы для долей.

Привет. Нужно оценить доверительный интервал (proportion_confint) для популяции майя с параметром method ='normal'. Проблема в том, что нижняя граница 0.0000, что не является правильным ответом.

При том, оценка с параметром method = 'wilson' рассчитана верно. Все остальные параметры идентичны.

Подскажите, что тут не так.

Python 3.8

np 1.18.1

pd 1.0.1

scipy 1.4.1

Привет. Нужно оценить доверительный интервал (proportion_confint) для популяции майя с параметром method ='normal'. Проблема в том, что нижняя граница 0.0000, что не является правильным ответом.

При том, оценка с параметром method = 'wilson' рассчитана верно. Все остальные параметры идентичны.

Подскажите, что тут не так.

Python 3.8

np 1.18.1

pd 1.0.1

scipy 1.4.1

А

Добрый день, проверьте, пожалуйста, мою работу С2W1

https://www.coursera.org/learn/supervised-learning/peer/bEMBK/linieinaia-rieghriessiia-i-osnovnyie-bibliotieki-python-dlia-analiza-dannykh-i/review/yMkYjKO9EeqfPgpD6FNHZQ

https://www.coursera.org/learn/supervised-learning/peer/bEMBK/linieinaia-rieghriessiia-i-osnovnyie-bibliotieki-python-dlia-analiza-dannykh-i/review/yMkYjKO9EeqfPgpD6FNHZQ