EE

Size: a a a

2021 March 17

Коллеги, подскажите пожалуйста. Есть ли какая-то разница для восстановления бэкапов в veeam для виртуалок vmware и виндовых физ машин сделанных veeam agent? При условии что прокси один на всех, бэкапы виртуалок и физ серверов лежат на одной nfs шаре и восстанавливаем в nfs-шару netapp. Проблема - если восстанавливать бэкап физ сервера через "export to vmdk", выбрать сервер esxi и далее подключеную датастору - восстановление идет directnfs по выделенной 10гбитной nfs-сети. Если сделать все тоже самое, но выбрать восстановление бэкапа виртуалки и далее "export vm files", выбираем файлы, сервер esxi и подключ датастору (идентично как и в восстановлении бэкапов физ машин), то задание упорно выполняется через сеть менеджемента 1гбитную

предполагаю, по тому что для ВМки при конвертации по дефолту диски тонкие, а тонкие диски восстанавливаются или через nbd или hotadd

EE

но имхо, не проверял, но посмотрел бы в эту сторону и попробовал сменить при экспорте на толстый

AS

предполагаю, по тому что для ВМки при конвертации по дефолту диски тонкие, а тонкие диски восстанавливаются или через nbd или hotadd

Так все наоборот.. для виртуалок при export vm files (которые в менедж сеть идет) нет возможности выбрать тонкий или толстый диск. А для бэкапов физмашин при export to vmdk можно указать тонкие или толстые (но у меня тут как раз в тонкий vmdk идет нормально по 10гбитной nfs сети)

AS

Попробую восстановить бэкап вмки, у которой толстый диск в esxi

EE

Так все наоборот.. для виртуалок при export vm files (которые в менедж сеть идет) нет возможности выбрать тонкий или толстый диск. А для бэкапов физмашин при export to vmdk можно указать тонкие или толстые (но у меня тут как раз в тонкий vmdk идет нормально по 10гбитной nfs сети)

If you export VMDK disks to a datastore, disks are saved in the thin provisioned format. If you export VMDK disks to a server, disks are saved in the thick format.

AS

If you export VMDK disks to a datastore, disks are saved in the thin provisioned format. If you export VMDK disks to a server, disks are saved in the thick format.

Я понял вроде, спасибо.. у меня к veeam не подключены напрямую nfs-шары netapp, и когда я выбираю куда делать export vm files бэкапа вм, то я выбираю сначала esxi хост (коьорый подключен к veeam) и уже тут выбираю датастору (которая как раз nfs-шара нетаппа). В этом случае восстановдение идет по дефолту в тонкий диск через менеджемент сеть esxi. То есть мне надо шары нетаппа подцепить к veeam и при восстановлении выбирать нужную шару

AS

Но не очень понятно почему бэкап физ машин при export to vmdk, выбрав esxi и шару и выбрав тонкий диск оно нормально улетает напрямую в nfs шару нэтаппа, минуя esxi

2021 March 18

VK

OU

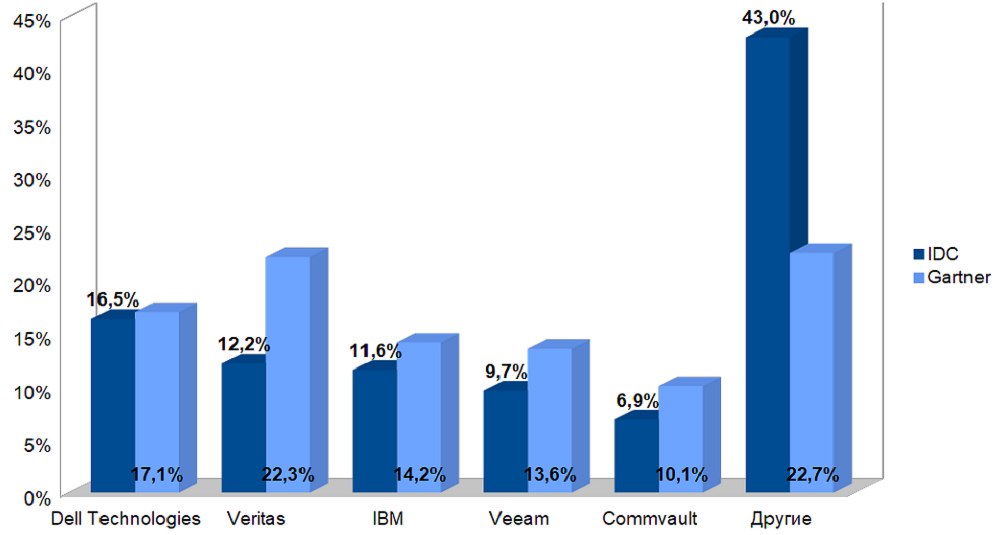

Вим всё ещё пятый

EE

так там данные за 19-й год….

VK

Вим всё ещё пятый

В 2 раза разброс оценки доли

VK

так там данные за 19-й год….

А есть свежее?

EE

IDC за 20-й год по-моему ещё не публиковал, как и гартнер

АБ

Товарищи, здравствуйте. 10-й вим, пытается сделать мёрдж на заполненном экстенте scalable repository. Как-то можно этому помешать?

P

Товарищи, здравствуйте. 10-й вим, пытается сделать мёрдж на заполненном экстенте scalable repository. Как-то можно этому помешать?

Отключить задание, расширить Scale-Out репу, запустить задание снова?

АБ

Отключить задание, расширить Scale-Out репу, запустить задание снова?

Эээ... В этой scale-out репе есть ещё экстентов, которые совсем даже не заполнены. То есть в целом на скейлауте места ещё навалом, просто вим неудачно выбирает экстент.

AZ

Эээ... В этой scale-out репе есть ещё экстентов, которые совсем даже не заполнены. То есть в целом на скейлауте места ещё навалом, просто вим неудачно выбирает экстент.

А какая политика выбрана? И не стоит ли принудительно складывать фуллы и инкременты вместе?

EE

Эээ... В этой scale-out репе есть ещё экстентов, которые совсем даже не заполнены. То есть в целом на скейлауте места ещё навалом, просто вим неудачно выбирает экстент.

если у вас в настройках собра стоит Data locality, он так и будет лить туда же, куда первый фулл сложил, сколько бы свободных экстентов у вас там не нашлось. используйте Performance

АБ

если у вас в настройках собра стоит Data locality, он так и будет лить туда же, куда первый фулл сложил, сколько бы свободных экстентов у вас там не нашлось. используйте Performance

Да, спасибо, так и есть. Уже исправляюсь.