КГ

Size: a a a

2021 March 30

Добрый день! Подскажите, метку данных можно как-либо выравнивать по левому/правому краю? Или проще заменить чем-то вроде сводной таблицы и фильтрами отбросить ненужные значения?

KK

Андрей В

Коллеги, здравствуйте!

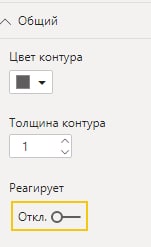

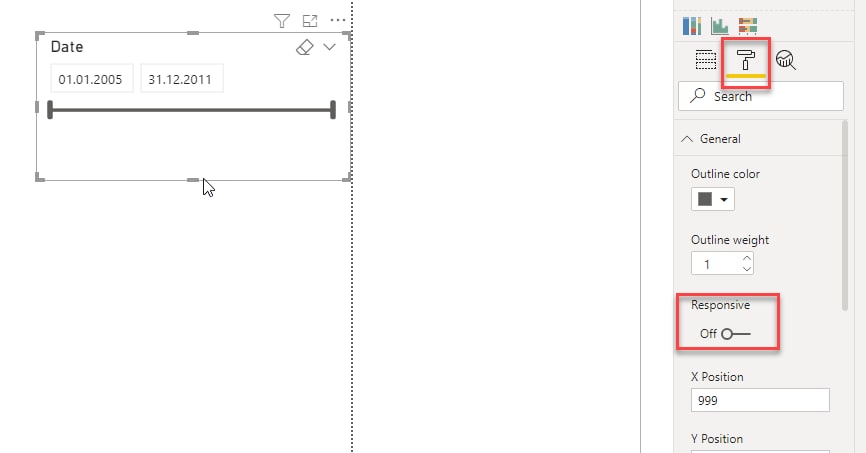

Подскажите пожалуйста, как сделать слайдер без круглого ползунка? Пример:

Подскажите пожалуйста, как сделать слайдер без круглого ползунка? Пример:

1

Андрей В

Коллеги, здравствуйте!

Подскажите пожалуйста, как сделать слайдер без круглого ползунка? Пример:

Подскажите пожалуйста, как сделать слайдер без круглого ползунка? Пример:

KK

Обогнал:-Р

KT

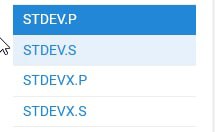

Коллеги, подскажите пжл, "стандартное отклонение" как посчитать его в BPI ?

АВ

@kkadikin, @InkognitoUser благодарю!

RG

Коллеги, подскажите пжл, "стандартное отклонение" как посчитать его в BPI ?

STDEV

1

Коллеги, подскажите пжл, "стандартное отклонение" как посчитать его в BPI ?

смотря что именно нужно

KT

Стандартное отклонение по полю

V

Коллеги, подскажите пжл, "стандартное отклонение" как посчитать его в BPI ?

А потом коэффициент вариации будете считать?)

S

1. Сколько таблиц в модели?

2. Сколько строк в самой большой таблице?

3. Какая самая большая гранулярность в модели?

4. Какие источники в модели?

2. Сколько строк в самой большой таблице?

3. Какая самая большая гранулярность в модели?

4. Какие источники в модели?

1. 11 таблиц

2. 42 млн

3. 9 полей в двух таблицах

4. sql и поток данных ( откуда я и забираю самую большую таблицу)

2. 42 млн

3. 9 полей в двух таблицах

4. sql и поток данных ( откуда я и забираю самую большую таблицу)

RG

Svetlana

Всем привет. Подскажите , может есть решение, как обойти в Power Pro лимит превышения датасета в 1Гб?

Direct query

SSAS

SSAS

IS

Svetlana

1. 11 таблиц

2. 42 млн

3. 9 полей в двух таблицах

4. sql и поток данных ( откуда я и забираю самую большую таблицу)

2. 42 млн

3. 9 полей в двух таблицах

4. sql и поток данных ( откуда я и забираю самую большую таблицу)

42млн не такая и большая модель. Третий вопрос это не количество полей, а поле с наибольшим количеством уникальных значений.

Вот у меня сейчас открыта модель 24,5млн строк в таблице фактов. Самый "тяжёлый" столбец с суммой, так как там 652тысячи уникальных значений. И размер модели в памяти 276,3мб. Поэтому если у вас нет какого то поля с большой гранулярностью, я бы сначала пересмотрел строение модели. Потом уже разные хитрости, которые предлагали: direct query, композитные модели, ssas и инкрементальное обновление.

Вот у меня сейчас открыта модель 24,5млн строк в таблице фактов. Самый "тяжёлый" столбец с суммой, так как там 652тысячи уникальных значений. И размер модели в памяти 276,3мб. Поэтому если у вас нет какого то поля с большой гранулярностью, я бы сначала пересмотрел строение модели. Потом уже разные хитрости, которые предлагали: direct query, композитные модели, ssas и инкрементальное обновление.

АМ

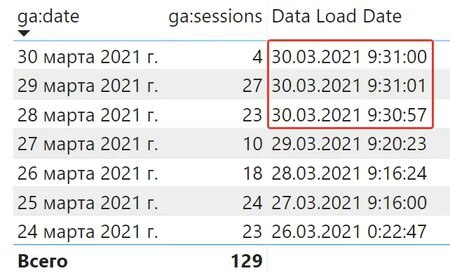

Недавно публиковал у себя на странице Facebook новость про инкрементное обновление кастомных коннекторов в Power BI (таких как Яндекс.Директ, Google Analytics и подобных).

Если кратко - теперь не надо каждый раз тянуть данные за несколько месяцев или лет. Можно дополнять отчёт данными за пару последних дней или недель.

Как этого добиться?

1) Создайте ограниченный динамическими датами запрос (например от 2daysAgo до yesterday).

2) Создайте 2 параметра - RangeStart и RangeEnd формата Дата + время. Неважно чему они будут равны в Power BI Desktop.

3) Зафильтруйте дату в запросе 2 созданными параметрами - Дата больше равна RangeStart И меньше RangeEnd.

4) Выгрузите результат в модель. Установите на табличку добавочное обновление - за сколько дней хотите обновлять её. Если один - будет обновляться за сегодня, если два - сегодня и вчера, итд.

Если запрос начинается с yesterday, то лучше всего ставить 1 день, если начинается с 2daysAgo, то ставим 2 дня, итд. Иначе он попытается получить данные за более ранний период, вытянет нулевое значение и оставит его в базе, а это нам не надо.

5) Выгрузите всё это в Power BI Service и установите расписание обновлений.

Как это работает:

Запрос всегда идёт в рамках дат, указанных в коннекторе (например от 2daysAgo до today). Но из-за добавочного обновления Power BI Service забирает только нужные ему даты и плюсует их к остальным данным. В итоге мы можем не тянуть статистику за весь период.

Если API в какой-то момент накосячит, например за 15 марта, то в отчёте останутся неправильные данные. Чтобы это исправить, рекомендую иметь отдельный необновляемый запрос с фиксированными датами за более ранний период. Например, запрос за январь-февраль 2021. Когда вы видите ошибку за 15-е марта 2021, вы добавляете в этот запрос половину марта, перетягивая ошибочные данные. И снова запускаете инкремент по новым датам. Я думаю ошибки будут очень редкими, но они бывают в любом API.

Мой запрос на скрине тянет последние пару дней, а статистика уже накопилась за неделю;)

https://yadi.sk/i/YIWXNbYGtXZrJg

Если кратко - теперь не надо каждый раз тянуть данные за несколько месяцев или лет. Можно дополнять отчёт данными за пару последних дней или недель.

Как этого добиться?

1) Создайте ограниченный динамическими датами запрос (например от 2daysAgo до yesterday).

2) Создайте 2 параметра - RangeStart и RangeEnd формата Дата + время. Неважно чему они будут равны в Power BI Desktop.

3) Зафильтруйте дату в запросе 2 созданными параметрами - Дата больше равна RangeStart И меньше RangeEnd.

4) Выгрузите результат в модель. Установите на табличку добавочное обновление - за сколько дней хотите обновлять её. Если один - будет обновляться за сегодня, если два - сегодня и вчера, итд.

Если запрос начинается с yesterday, то лучше всего ставить 1 день, если начинается с 2daysAgo, то ставим 2 дня, итд. Иначе он попытается получить данные за более ранний период, вытянет нулевое значение и оставит его в базе, а это нам не надо.

5) Выгрузите всё это в Power BI Service и установите расписание обновлений.

Как это работает:

Запрос всегда идёт в рамках дат, указанных в коннекторе (например от 2daysAgo до today). Но из-за добавочного обновления Power BI Service забирает только нужные ему даты и плюсует их к остальным данным. В итоге мы можем не тянуть статистику за весь период.

Если API в какой-то момент накосячит, например за 15 марта, то в отчёте останутся неправильные данные. Чтобы это исправить, рекомендую иметь отдельный необновляемый запрос с фиксированными датами за более ранний период. Например, запрос за январь-февраль 2021. Когда вы видите ошибку за 15-е марта 2021, вы добавляете в этот запрос половину марта, перетягивая ошибочные данные. И снова запускаете инкремент по новым датам. Я думаю ошибки будут очень редкими, но они бывают в любом API.

Мой запрос на скрине тянет последние пару дней, а статистика уже накопилась за неделю;)

https://yadi.sk/i/YIWXNbYGtXZrJg

IS

42млн не такая и большая модель. Третий вопрос это не количество полей, а поле с наибольшим количеством уникальных значений.

Вот у меня сейчас открыта модель 24,5млн строк в таблице фактов. Самый "тяжёлый" столбец с суммой, так как там 652тысячи уникальных значений. И размер модели в памяти 276,3мб. Поэтому если у вас нет какого то поля с большой гранулярностью, я бы сначала пересмотрел строение модели. Потом уже разные хитрости, которые предлагали: direct query, композитные модели, ssas и инкрементальное обновление.

Вот у меня сейчас открыта модель 24,5млн строк в таблице фактов. Самый "тяжёлый" столбец с суммой, так как там 652тысячи уникальных значений. И размер модели в памяти 276,3мб. Поэтому если у вас нет какого то поля с большой гранулярностью, я бы сначала пересмотрел строение модели. Потом уже разные хитрости, которые предлагали: direct query, композитные модели, ssas и инкрементальное обновление.

@evseevs про оптимизацию. В данной модели столбец сумма - это деньги, в исходнике суммы хранятся с кучей знаков после запятой. Так как масштабы такие, что копейки никому не интересны, я спокойно перед загрузкой округлил суммы до двух знаков после запятой, что дало сокращение уникальных значений с 652125 до 497291 уникальных значений, а размер модели уменьшился на 36мб, а это более 10% объёма

MZ

@evseevs про оптимизацию. В данной модели столбец сумма - это деньги, в исходнике суммы хранятся с кучей знаков после запятой. Так как масштабы такие, что копейки никому не интересны, я спокойно перед загрузкой округлил суммы до двух знаков после запятой, что дало сокращение уникальных значений с 652125 до 497291 уникальных значений, а размер модели уменьшился на 36мб, а это более 10% объёма

А развел бы на рубли и копейки по разным столбцам как int - вообще удивился бы ) у второго столбца максимальная кардинальность 100.

KK

Maxim Zelensky

А развел бы на рубли и копейки по разным столбцам как int - вообще удивился бы ) у второго столбца максимальная кардинальность 100.

А я бы вообще до рубля отрезал)

MZ

Но зависимость, конечно, не прямая

MZ

А я бы вообще до рубля отрезал)

Тебе дай волю ))

IS

Maxim Zelensky

А развел бы на рубли и копейки по разным столбцам как int - вообще удивился бы ) у второго столбца максимальная кардинальность 100.

Ну Макс, это понятно)) мы же ищем оптимальное сочетание